Fondée en 1993, Nvidia est un jeune par rapport à d’autres sociétés de semi-conducteurs. Cependant, son impact sur le monde de la technologie a été considérable. Selon l’enquête sur le matériel Steam, plus de 80% des utilisateurs ont une carte graphique Nvidia dans leur système de jeu, tandis que Passmark indique que plus de 60% des utilisateurs ont un produit Nvidia.

Il y avait beaucoup de travail à faire pour atteindre ce niveau, et alors que la première puce de la société en 1995, la NV1 semblait être un produit brillant offrant une accélération vidéo et 3D, une carte son intégrée et un port de manette de jeu, sa dépendance sur Le mappage de texture quadratique plutôt que le rendu de polygones triangulaires signifiait que Nvidia a laissé tomber la balle lors de ses grands débuts. Leçon apprise car les jetons qui ont suivi comprenaient des succès infaillibles. Nous allons jeter un coup d’oeil.

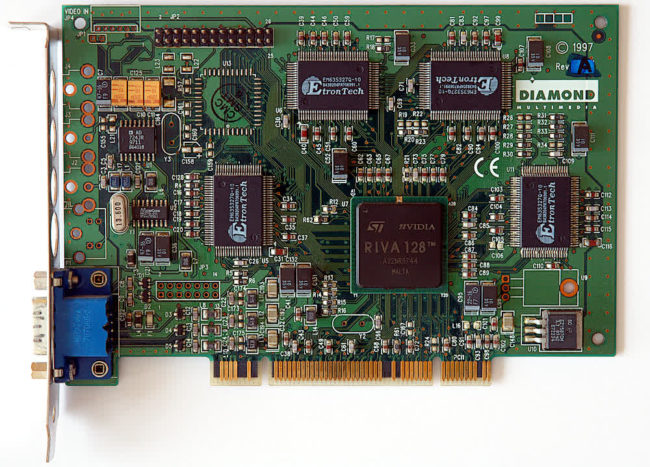

Nvidia RIVA 128

Image: André Karwath

Un acronyme pour Vidéo et animation interactives en temps réel accélérateur, le RIVA 128 a été le successeur du NV1 et un produit qui a mis tout le monde dans l’espace en alerte. Prenant en charge DirectX 5 et OpenGL, le RIVA 128 n’a pas répété les mêmes erreurs. Il semblait être à l’épreuve du temps dès le départ, avec 4 Mo de support SGRAM et AGP 2X.

À l’époque, il pouvait suivre le rythme des cartes 3Dfx Voodoo, qui étaient les cartes les plus rapides du marché. Plus d’un million d’unités expédiées dans les 4 premiers mois suivant la sortie du RIVA 128, renforçant ainsi son importance en tant que produit et en tant qu’entreprise.

Nvidia RIVA TNT2

Successeur du RIVA 128, le TNT était bon mais était toujours surpassé par 3Dfx. Mais l’année suivante, Nvidia a livré le TNT2 avec plusieurs améliorations significatives. Un processus de réduction à 250 nm (et plus tard à 220 nm avec le TNT2 Pro) permettait des vitesses d’horloge plus élevées (125 MHz core et 150 MHz sur la mémoire, par rapport à 90/110 sur le TNT d’origine), tandis que la puce supportait des textures plus grandes, un tampon Z 32 bits, AGP 4X et un maximum de 32 Mo de mémoire.

Par rapport aux produits concurrents de 3Dfx, le TNT2 offrait un meilleur support pour DirectX et OpenGL et offrait une excellente qualité d’image avec des couleurs 32 bits. Les joueurs ont remarqué.

Nvidia GeForce 256 DDR

En 1999, Nvidia a présenté la première puce GeForce, connue sous le nom de GeForce 256. Il y avait deux variantes, le modèle DDR haut de gamme attirant l’essentiel de l’attention pour sa mémoire rapide.

La GeForce 256 comportait également un moteur de transformation et d’éclairage (T&L) qui permettait à la puce de gérer les calculs précédemment couverts par le processeur. Cette fonctionnalité a permis à la carte d’être associée à un processeur plus lent tout en offrant d’excellentes performances. Bien que les critiques et les rivaux aient déclaré que la technologie n’était pas nécessaire, elle est finalement devenue courante et se retrouve dans presque toutes les cartes graphiques du marché.

La GeForce 256 a également été la base du premier produit Quadro pour la conception assistée par ordinateur. Cette gamme de produits a ouvert un tout nouveau marché lucratif pour Nvidia.

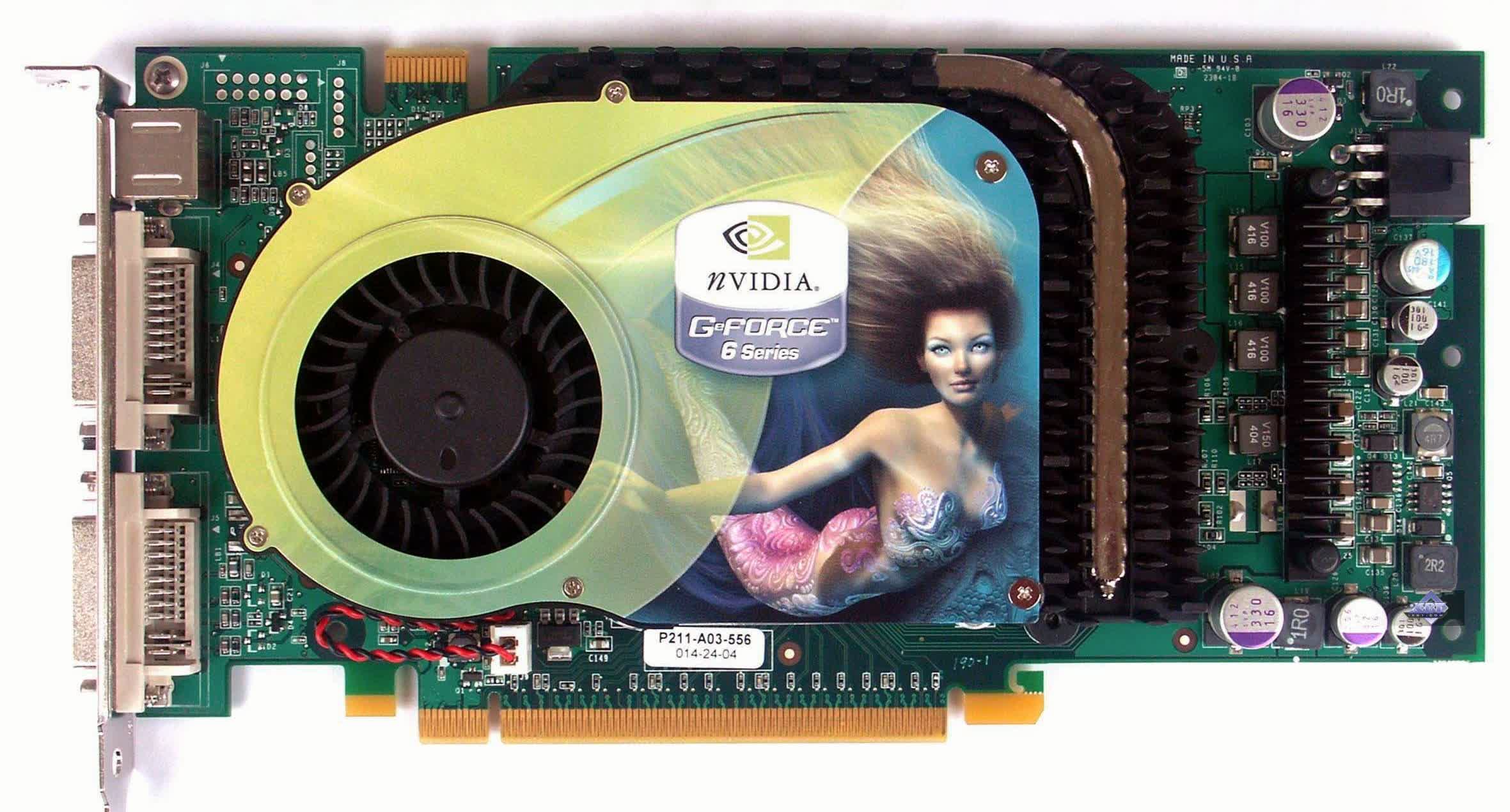

Série Nvidia GeForce 6800

Le début des années 2000 s’est transformé en un grondement royal entre ATI et Nvidia, alors qu’ils se sont affrontés à travers les époques GeForce 2, 3 et 4. Après qu’ATI ait abandonné sa Radeon 9700 et impressionné tout le monde, Nvidia a dû lancer son propre haymaker, et c’est ainsi que la GeForce 6800 a été introduite.

En tant que l’un des premiers produits à utiliser la mémoire GDDR3, la GeForce 6800 était un démon de la vitesse, rejetant même le X800 XT d’ATI avec une meilleure prise en charge du modèle de shader et une précision du point flottant 32 bits, par rapport à la Radeon. De plus, depuis que Nvidia avait acquis 3Dfx, ils ont commencé à implémenter les fonctionnalités et la technologie de l’ancienne société graphique.

Une partie majeure du portefeuille de 3Dfx était Scan-Line Interleave, qui reliait deux cartes vidéo et augmentait la puissance de traitement 3D disponible. En 2004, Nvidia a modernisé cette fonctionnalité et l’a réintroduite en tant qu’interface de liaison évolutive (SLI) avec de nombreux passionnés associant des 6800 pour créer le PC de jeu ultime.

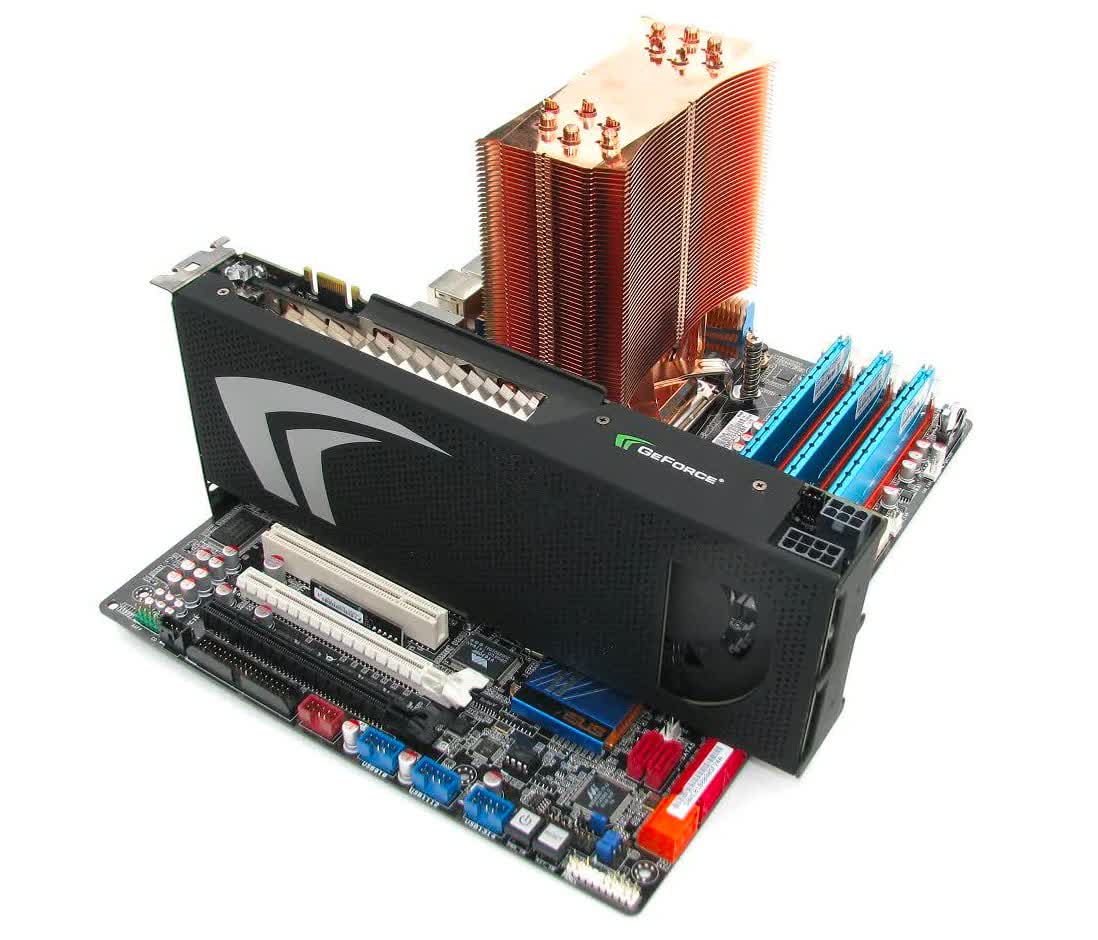

Série Nvidia GeForce 8800

Deux ans après la GeForce 6800, Nvidia a présenté la nouvelle série GeForce 8800. La nouvelle carte graphique était une bête absolue d’un GPU de jeu. Avec jusqu’à 128 processeurs de streaming, un cœur de 575 MHz, une horloge de shader de 1,35 GHz et 768 Mo de GDDR3, il pourrait en fait surpasser un double GPU phare de la génération précédente.

C’était l’un des premiers produits à utiliser une architecture de shader unifiée. La série GeForce 8 était considérée comme rapide même des années après ses débuts. Tout n’était pas de la sauce, car un nombre important de puces de cette série souffraient d’un problème de surchauffe qui a conduit à de nombreuses pannes.

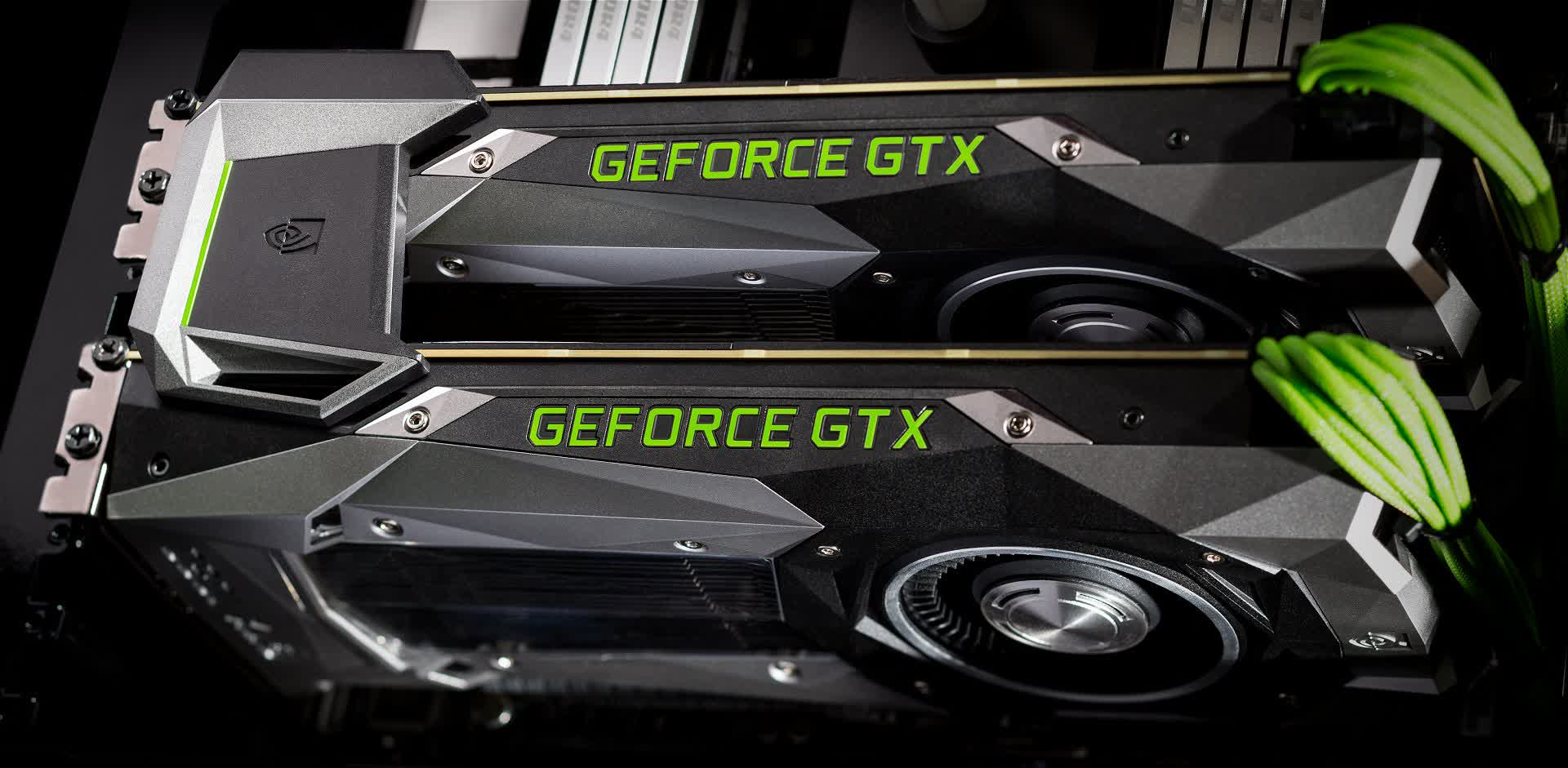

Nvidia GeForce GTX 295

Juste avant l’arrivée des années 2010, les cartes à double GPU sont devenues une denrée populaire, et AMD était assez agressif avec son ATI Radeon 4870 x2. Pour rivaliser avec cela, Nvidia a sorti la GeForce GTX 295, qui a mis deux de ses puces GeForce 200 sur une seule carte.

Avec les bons pilotes, c’était la carte graphique la plus rapide que l’argent puisse acheter, et à 500 $, elle pouvait surpasser une paire de GTX 260 alors qu’une seule avait un PDSF de 450 $, ce qui en faisait une bonne affaire pour les amateurs.

Nvidia GeForce GTX 580

Bien que le lancement de la GeForce GTX 480 ne se soit pas déroulé comme prévu, tout allait bien avec son successeur connu sous le nom de GTX 580. Une architecture Fermi totalement libérée signifiait 16 clusters multiprocesseurs de flux, six contrôleurs de mémoire actifs 64 bits et un filtrage FP16 pleine vitesse .

Cette carte graphique était la vraie affaire. Avec AMD sur ses talons, la GTX 580 devait être tout ce que la GTX 480 n’était pas, et heureusement, elle suffisait à retenir AMD pendant un certain temps. La GTX 590 à double GPU de premier plan a été accueillie avec des critiques cinglantes en raison de sa faible stabilité et de l’incapacité de surclasser la Radeon HD 6990.

SoC Nvidia Tegra X1

Nvidia fabriquait des produits pour les passionnés de PC, les professionnels de la conception et même les supercalculateurs et les chercheurs en IA, mais avec les SoC Tegra, il a effectivement fait le saut dans le monde de l’informatique mobile.

La gamme Tegra basée sur Arm a été conçue pour les smartphones et les tablettes, mais les choses sont allées au-delà de cela, et la puissance de traitement supplémentaire du SoC a été utilisée à bon escient dans la Nintendo Switch. Le succès du Switch est hors du commun, avec près de 70 millions d’unités vendues depuis 2017. Chacun contient le Tegra X1, qui associe un quadricœur ARMv8 ARM Cortex-A57 à un GPU à 256 cœurs basé sur Maxwell.

Nvidia GeForce GTX 1080

La série 16nm GeForce GTX 1080 a été extrêmement influente et a marqué une étape importante pour le fabricant de GPU, mettant en valeur la puissance et l’expertise en conception de Nvidia. L’architecture Pascal était bien en avance sur la concurrence, à tel point que les cartes GeForce GTX 10 sont restées en lice pendant plusieurs années, ce qui est presque une anomalie sur le marché graphique.

La GTX 1080 est devenue la référence à battre, et même la prochaine génération de GPU Nvidia a eu du mal à montrer une amélioration significative des performances raster. La mémoire GDDR5X rapide a été associée à 2560 cœurs dans la GTX 1080 et à 3584 cœurs dans la GTX 1080 Ti, ce qui a entraîné des fréquences d’images époustouflantes même lorsque vous augmentez les résolutions.

Nvidia GeForce RTX 3080

La GTX 1080 a été suivie par la série RTX 20 alimentée par Turing, qui a mis en œuvre pour la première fois le traçage de rayons matériel en temps réel dans une carte vidéo grand public. Cependant, au moment de sa sortie, il y avait très peu de jeux avec des fonctionnalités de traçage de rayons, et en général, la série RTX 20 ne semblait pas être un saut assez significatif par rapport à la série GTX 10.

Nvidia a fait monter les enchères avec la série RTX 30, qui utilisait l’architecture Ampere, ce qui a conduit la RTX 3080 à devenir la carte de jeu ultime quelle que soit la résolution ou permettant des fonctionnalités de traçage de rayons exigeantes lors de l’utilisation de DLSS. Le 3080 possède 28,3 milliards de transistors et 8704 cœurs cadencés jusqu’à 1,7 GHz, offrant un bond de 70% des performances par rapport au RTX 2080 en 4K est impressionnant.

Sur le plan moins positif, la carte ne dispose que de 10 Go de mémoire, bien qu’il s’agisse du type GDDR6X le plus rapide. Il est également gourmand en énergie, mais il est très rapide et malgré le PDSF de 700 $, cela pourrait être considéré comme une bonne affaire pour les amateurs, grâce à un faible coût par image.

Emballer

Nvidia est devenu un géant du graphisme et au-delà, en produisant régulièrement des produits impressionnants et innovants pour les joueurs et les passionnés d’informatique, mais plus récemment en fournissant également des solutions pour les constructeurs automobiles, les studios de création et les chercheurs. Sans parler de l’acquisition imminente d’Arm.

Ces jours-ci, Nvidia pousse les efforts de ses produits de traçage de rayons matériels en temps réel, qui permettent un éclairage photoréaliste. Cependant, même sans ces fonctionnalités, ses GPU sont parmi les plus performants du secteur. Alors que nous nous asseyons sur une nouvelle génération de jeux, avec de nouvelles consoles prenant en charge le traçage de rayons, il sera intéressant de voir si Nvidia peut augmenter son avance sur la concurrence.

***

25 ans plus tard: combien en avez-vous possédé?

Ne manquez pas non plus notre fonctionnalité parallèle présentant les 10 GPU AMD / ATI les plus importants.