Presque tous les PC de bureau en ont un. Ils ont des milliards de transistors, peuvent utiliser des centaines de watts de puissance et peuvent coûter plus de mille dollars. Ce sont des chefs-d'œuvre de l'ingénierie électronique et génèrent des extrêmes de fidélité et de dédain envers les produits … et pourtant, le nombre de choses qu'ils font normalement peut être compté d'une seule main. Bienvenue dans le monde des cartes graphiques!

Les cartes graphiques font partie des composants PC auxquels nous consacrons le plus de temps sur , il est donc clair qu'elles nécessitent une dissection appropriée. Rassemblons l'équipe et dirigeons-nous vers la table d'opération. Il est temps de se plonger dans les entrailles qui composent une carte graphique, de diviser ses différentes parties et de voir ce que fait chaque bit.

Entrez dans le dragon

Ah, l'humble carte graphique, ou pour lui donner un titre plus complet: le carte d'extension d'accélération vidéo. Conçus et fabriqués par des entreprises mondiales de plusieurs milliards de dollars, ils sont souvent le composant le plus grand et le plus cher d'un ordinateur de bureau.

En ce moment sur Amazon, les 10 meilleures ventes vont de 53 $ à 1 200 $, avec ce dernier en poids de 3,3 livres (1,5 kg) et plus de 12 pouces (31 cm) de longueur. Et tout cela est à faire quoi, exactement? Utilisez des puces de silicium sur une carte de circuit imprimé pour, pour la plupart des utilisateurs, créer des graphiques 2D et 3D et encoder / décoder des signaux vidéo.

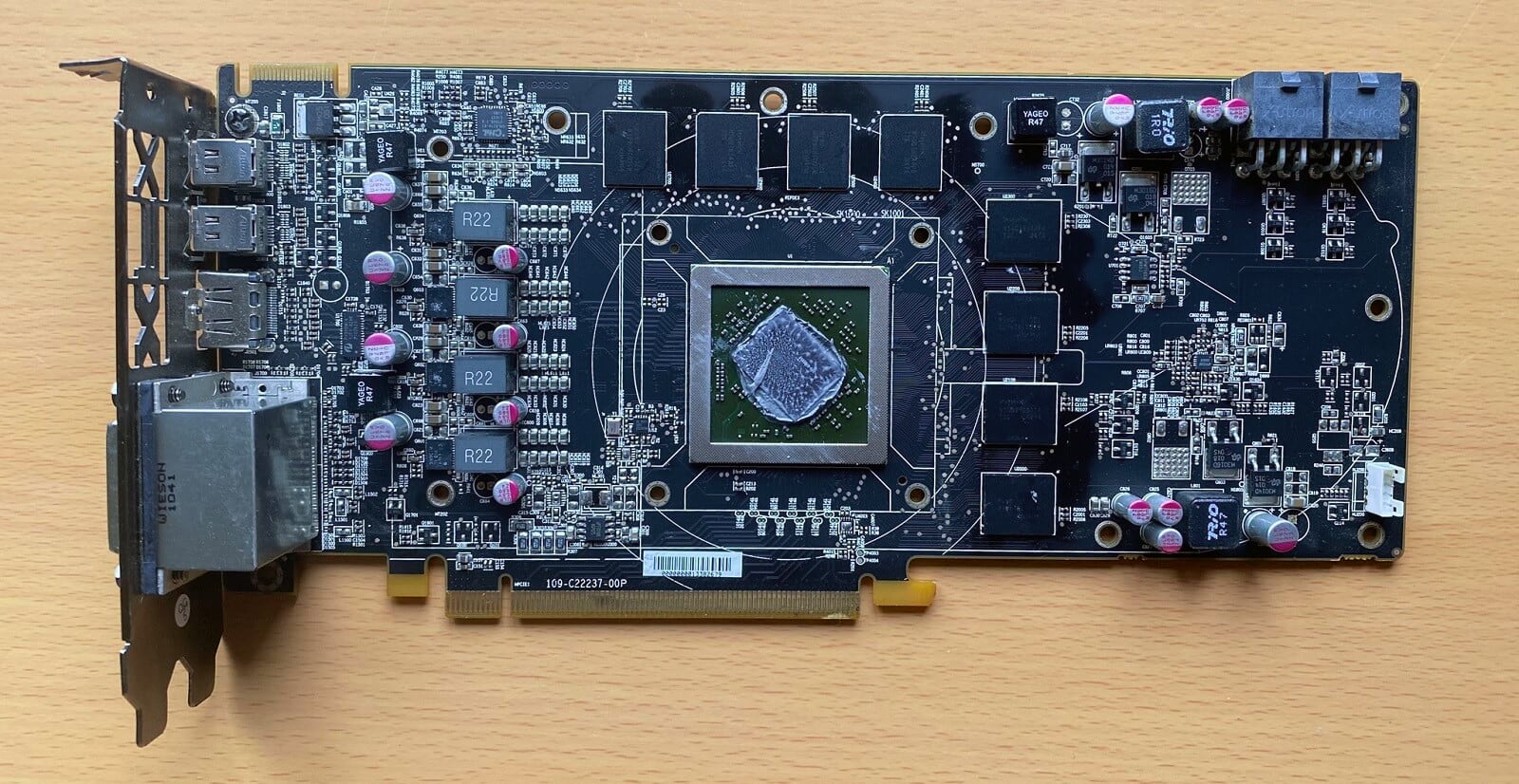

Cela ressemble à beaucoup de métal, de plastique et d'argent pour faire quelques petites choses, alors nous ferions mieux de rester coincés en un et de voir pourquoi ils sont comme ça. Pour cette pièce d'anatomie, nous utilisons une carte graphique fabriquée par XFX, une Radeon HD 6870 comme celle que nous avons testée en octobre 2010.

Les premiers regards ne révèlent pas grand-chose: il est assez long à près de 7 pouces (22 cm) mais la plupart semble être en plastique. Nous pouvons voir un support métallique, pour le maintenir fermement en place dans l'ordinateur, un gros ventilateur rouge et un connecteur de carte de circuit imprimé.

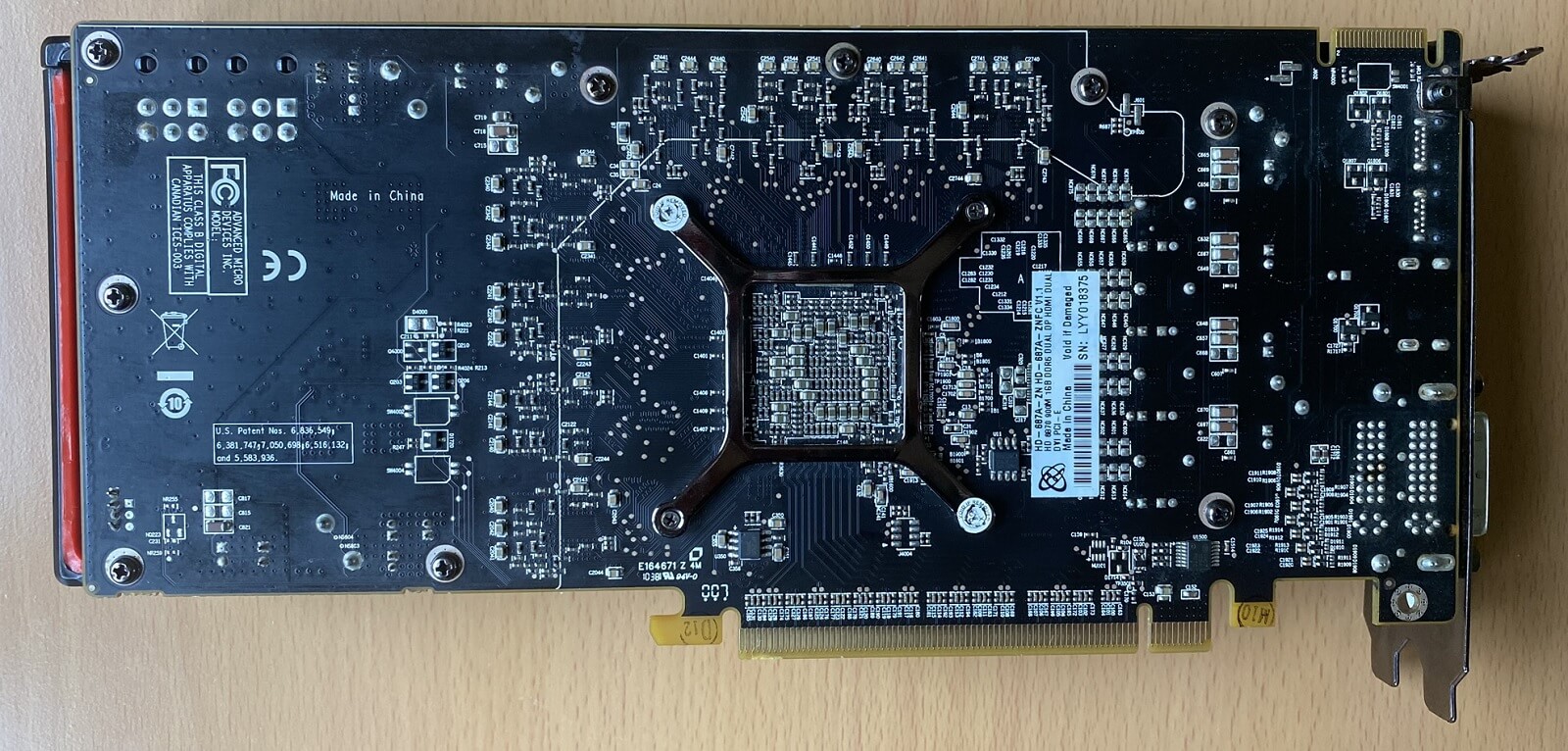

Tournons-le et voyons s'il y a plus à voir de l'autre côté:

La première chose que vous remarquez est un autre support métallique, encadrant toute une série de composants électroniques. Le reste de la carte de circuit imprimé est raisonnablement vide, mais nous pouvons voir beaucoup de fils de connexion provenant de la section centrale, donc il y a évidemment quelque chose d'important là-bas et cela doit être assez complexe …

Il fait chaud ici!

Tous les jetons sont circuits intégrés (IC, pour faire court) et ils génèrent de la chaleur lorsqu'ils travaillent. Les cartes graphiques ont milliers d'entre eux emballés dans un petit volume, ce qui signifie qu'ils seront assez grillés si la chaleur n'est pas gérée d'une manière ou d'une autre.

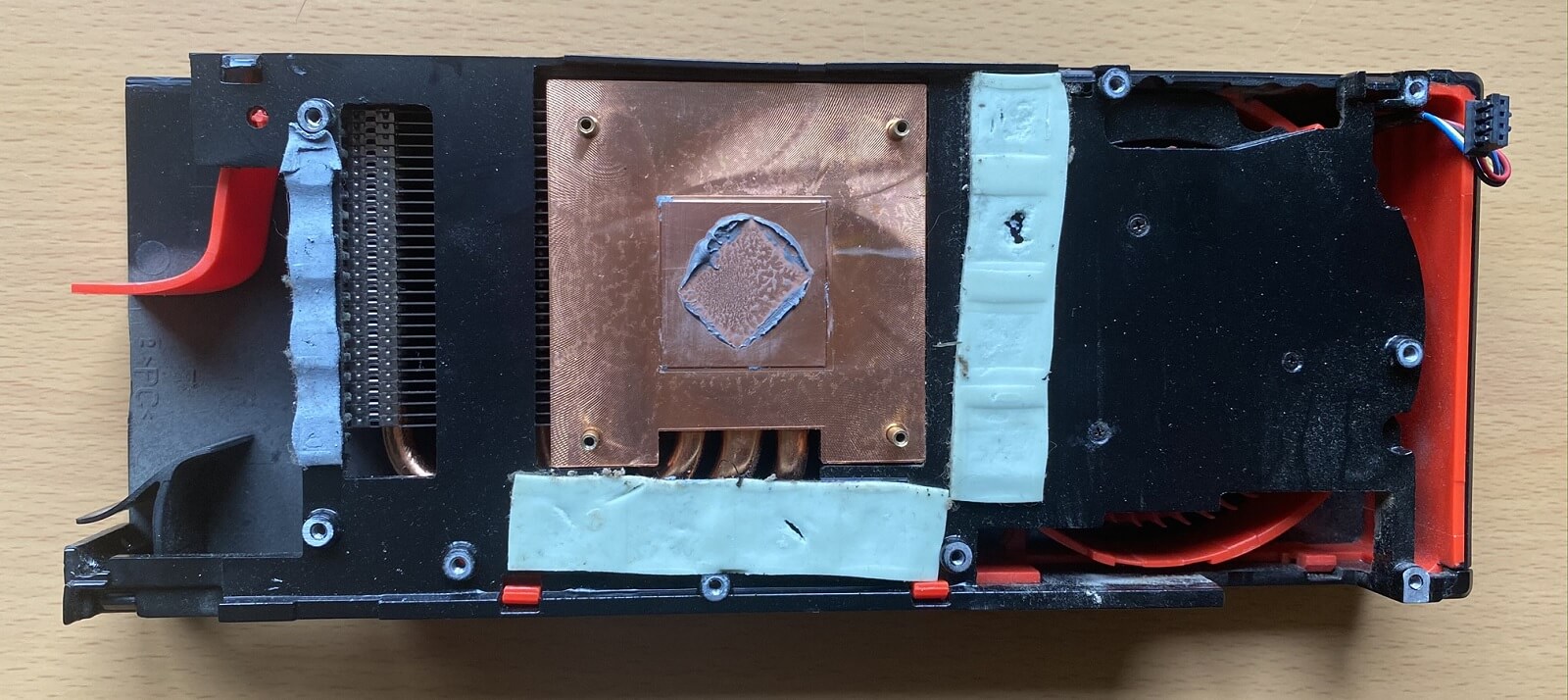

En conséquence, la plupart des cartes graphiques sont cachées sous une sorte de système de refroidissement et la nôtre ne fait pas exception. Avec les tournevis et avec un mépris flagrant pour les autocollants d'avertissement de garantie … c'est une assez vieille unité de toute façon:

Ce système de refroidissement est généralement connu sous le nom de type « souffleur '': il aspire l'air de l'intérieur du boîtier de l'ordinateur et le conduit à travers un gros morceau de métal, avant de le faire sauter hors du boîtier.

Dans l'image ci-dessus, nous pouvons voir le bloc de métal et y coller sont les restes d'une substance qui coule généralement connue sous le nom de pâte thermique. Son travail consiste à combler les lacunes microscopiques entre le processeur graphique (alias le GPU) et le bloc métallique, afin que la chaleur soit transférée plus efficacement.

On peut également voir 3 bandes bleues appelées coussinets thermiques, car le matériau souple et spongieux offre un meilleur contact entre certaines parties de la carte de circuit imprimé et la base du refroidisseur (qui est également en métal). Sans ces bandes, ces pièces toucheraient à peine, voire pas du tout, la plaque métallique et ne seraient pas refroidies.

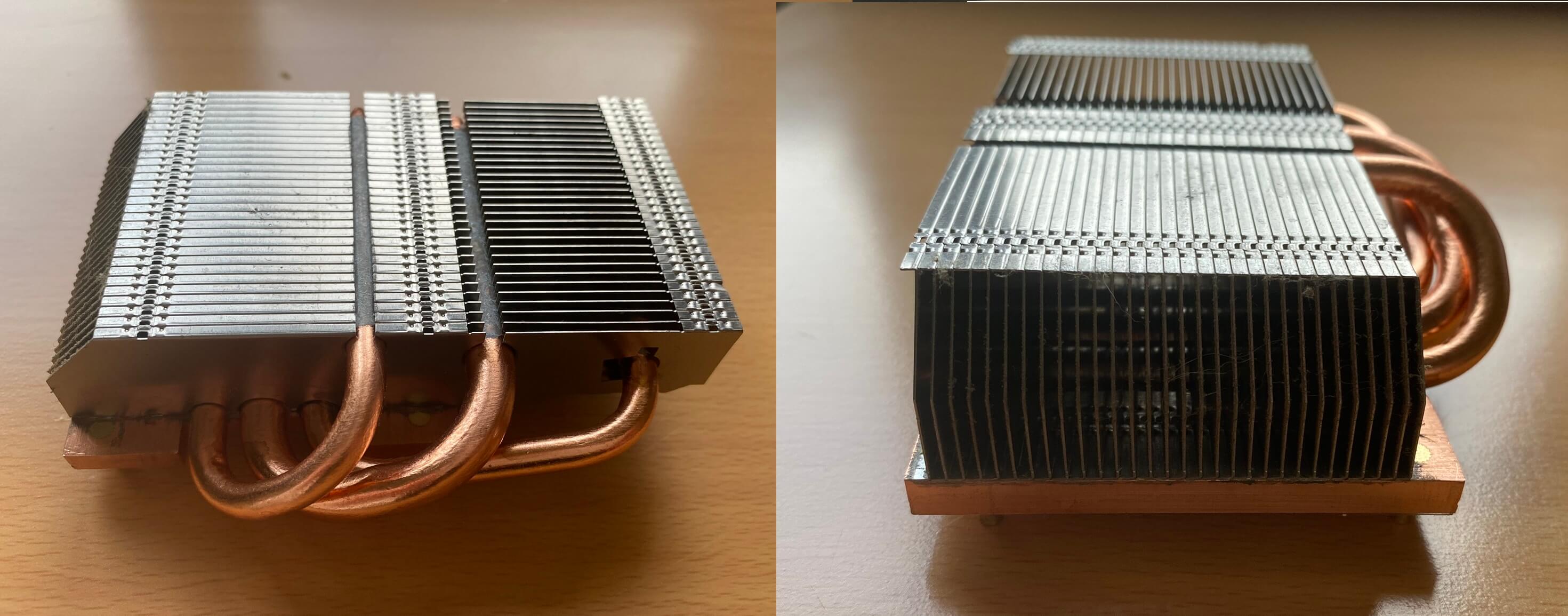

Examinons de plus près le gros morceau de métal – dans notre exemple, c'est un bloc de cuivre, avec 3 tuyaux en cuivre qui s'en détachent, en plusieurs rangées d'ailettes en aluminium. Le nom de tout est un dissipateur de chaleur.

Les tuyaux sont creux et scellés aux deux extrémités; à l'intérieur, il y a une petite quantité d'eau (dans certains modèles, c'est de l'ammoniac) qui absorbe la chaleur du bloc de cuivre. Finalement, l'eau se réchauffe tellement qu'elle se transforme en vapeur et s'éloigne de la source de chaleur, à l'autre extrémité du tuyau.

Là, il transfère la chaleur aux ailettes en aluminium, se refroidissant dans le processus et redevenant liquide. La surface intérieure des tuyaux est rugueuse et une action capillaire (également appelée mèche) transporte l'eau sur cette surface jusqu'à ce qu'elle atteigne à nouveau la plaque de cuivre.

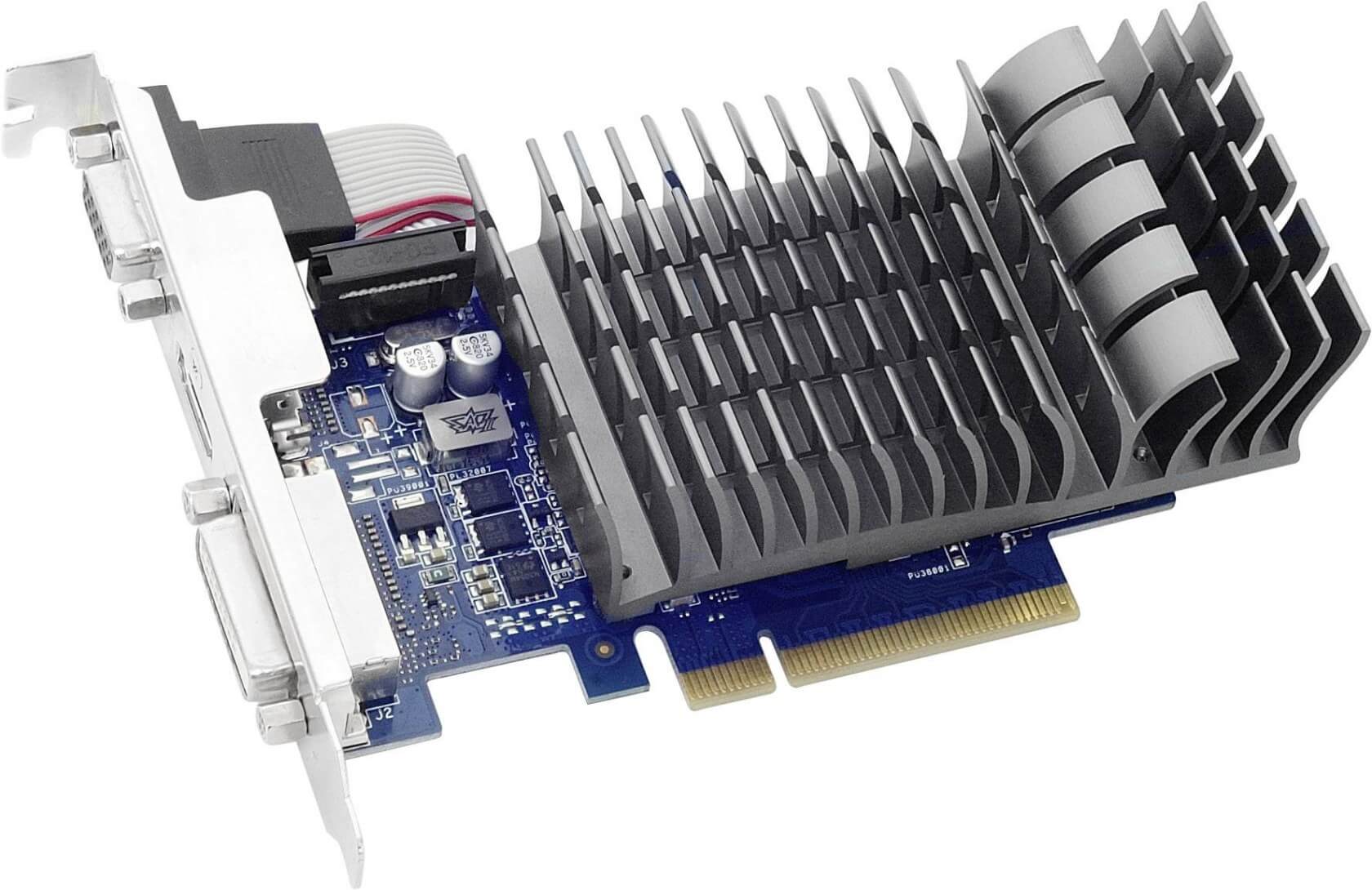

Caloducs, comme on les appelle communément, n'apparaissent pas sur toutes les cartes graphiques. Un modèle bas de gamme économique ne produira pas beaucoup de chaleur et n'en aura donc pas besoin. Les mêmes modèles n'utilisent souvent pas de cuivre pour le dissipateur thermique, pour économiser de l'argent, comme indiqué dans l'image ci-dessous.

Cette Asus GeForce GT 710 montre l'approche typique du marché des cartes graphiques bas de gamme et à faible consommation. De tels produits utilisent rarement plus de 20 W d'énergie électrique, et même si la majeure partie de cela se retrouve sous forme de chaleur, ce n'est tout simplement pas suffisant pour déranger la puce cachée sous le refroidisseur.

Un problème avec le type de refroidisseur à ventilateur est que le ventilateur utilisé pour souffler de l'air à travers les ailettes métalliques (puis hors du boîtier du PC), a un travail difficile à faire et ils ne sont généralement pas plus larges que la carte graphique elle-même. Cela signifie qu'ils doivent tourner assez rapidement, ce qui génère beaucoup de bruit.

La solution commune à ce problème est la ouvert plus frais – ici, le ventilateur dirige simplement l'air vers le bas dans les ailettes, et le reste du plastique / métal entourant le ventilateur laisse juste cet air chaud dans le boîtier du PC. L'avantage de cela est que les ventilateurs peuvent être plus gros et tourner plus lentement, ce qui donne généralement une carte graphique plus silencieuse. Le mauvais côté? La carte est plus volumineuse et la température intérieure de l'ordinateur sera plus élevée.

Bien sûr, vous ne le faites pas avoir d'utiliser l'air pour aller tout Netflix et se détendre avec votre carte graphique. L'eau est vraiment bonne pour absorber la chaleur, avant qu'elle ne monte en température (environ 4 fois mieux que l'air), vous pouvez donc naturellement acheter des kits de refroidissement par eau et les installer, ou vendre un ou deux reins, et acheter une carte graphique avec une déjà installée .

La carte ci-dessus est GeForce RTX 2080 Ti KiNGPiN GAMING d'EVGA – le refroidisseur de ventilateur est juste pour la RAM et d'autres composants sur la carte de circuit imprimé; la puce de traitement principale est refroidie par eau. À vous pour un coup de pouce à 1 800 $.

Vous serez peut-être surpris de savoir que le RTX 2080 Ti a une consommation électrique maximale «normale» de 250 W, ce qui est Moins que le RX 5700 XT nous l'avons mentionné un peu plus tôt.

De tels systèmes de refroidissement excessifs ne sont pas là pour les réglages quotidiens: cependant, vous iriez avec l'une de ces configurations, si vous voulez augmenter les tensions et les vitesses d'horloge à des niveaux ridicules, et cracher du feu comme un vrai dragon.

Le cerveau derrière le muscle: entrez dans le GPU

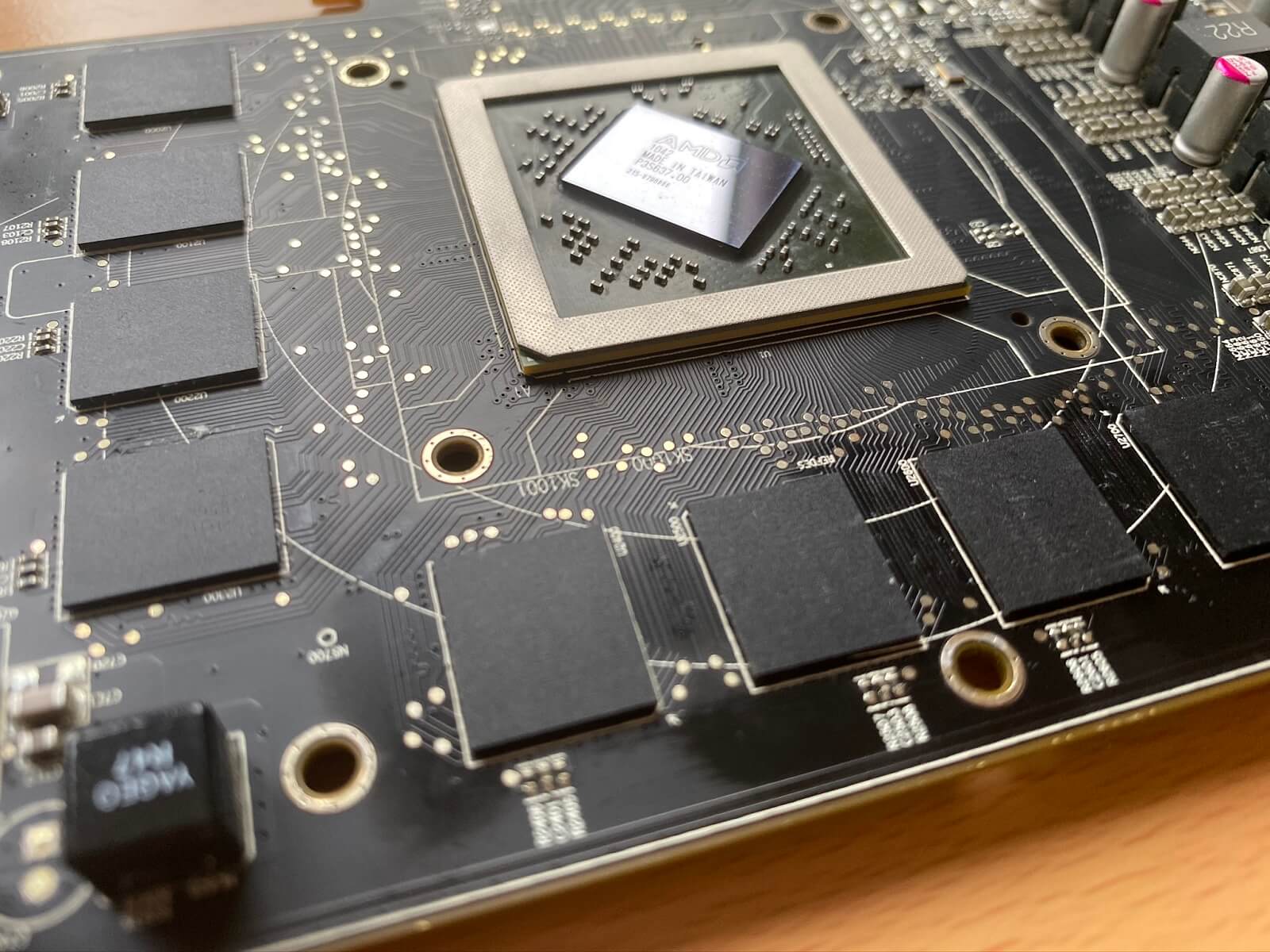

Maintenant que nous avons retiré le système de refroidissement de notre carte graphique, voyons ce que nous avons: une carte de circuit imprimé avec une puce volumineuse au milieu, entourée de petites puces noires et une pléthore de composants électriques partout ailleurs.

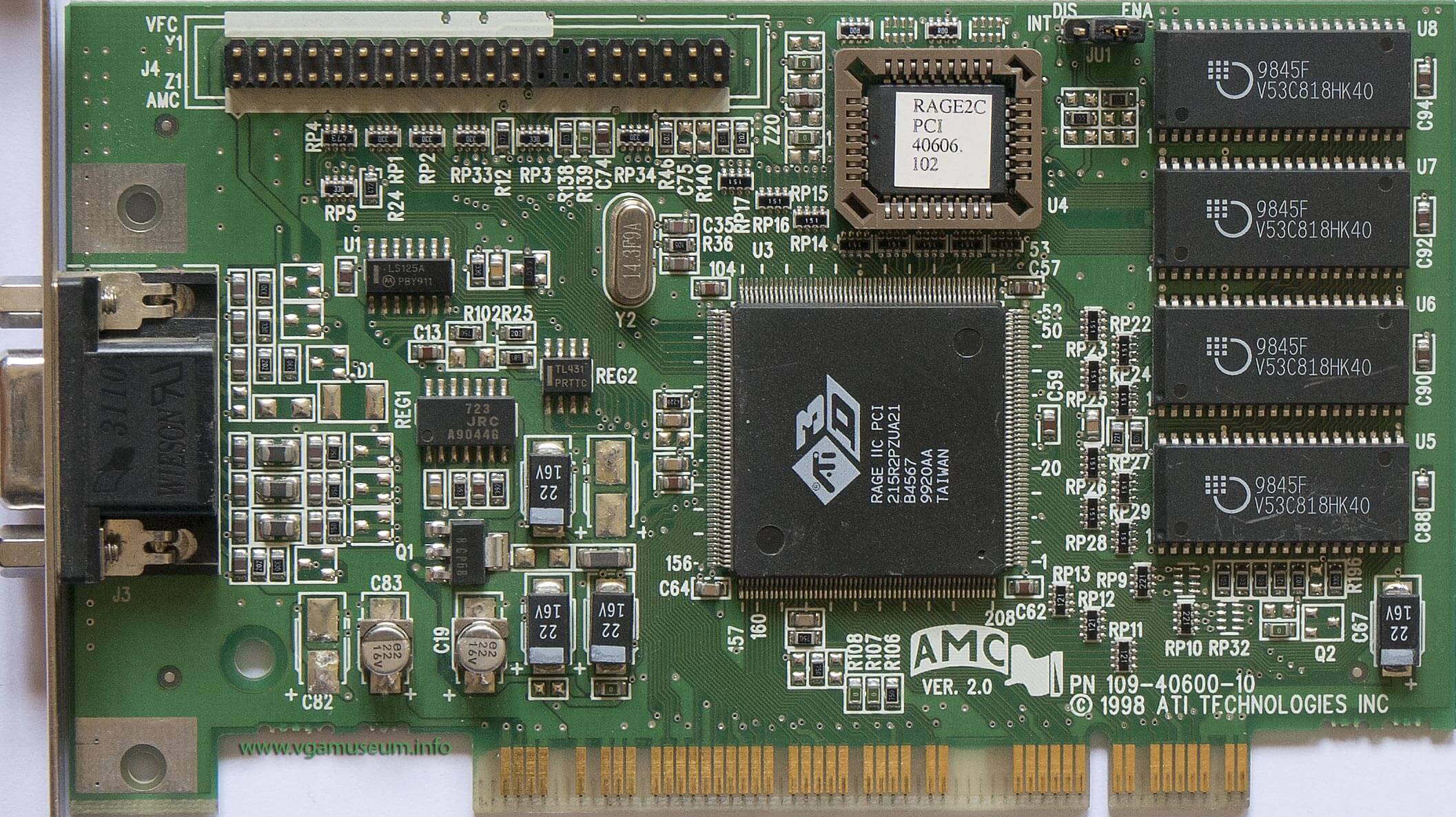

Quelle que soit la carte graphique que vous possédez, elles ont toutes le même type de pièces et suivent une disposition similaire. Même si nous remontons à 1998 et que nous regardons une ancienne carte graphique ATi Technologies, vous pouvez toujours voir à peu près la même chose:

Comme notre HD 6870 démonté, il y a une grande puce au milieu, de la mémoire et un tas de composants pour que tout fonctionne.

Le gros processeur porte plusieurs noms: adaptateur vidéo, accélérateur 2D / 3D, puce graphique pour en nommer quelques uns. Mais ces jours-ci, nous avons tendance à appeler cela un processeur graphique ou GPU, pour faire court. Ces 3 lettres sont utilisées depuis des décennies, mais Nvidia prétendra qu'elles ont été les premières à l'utiliser.

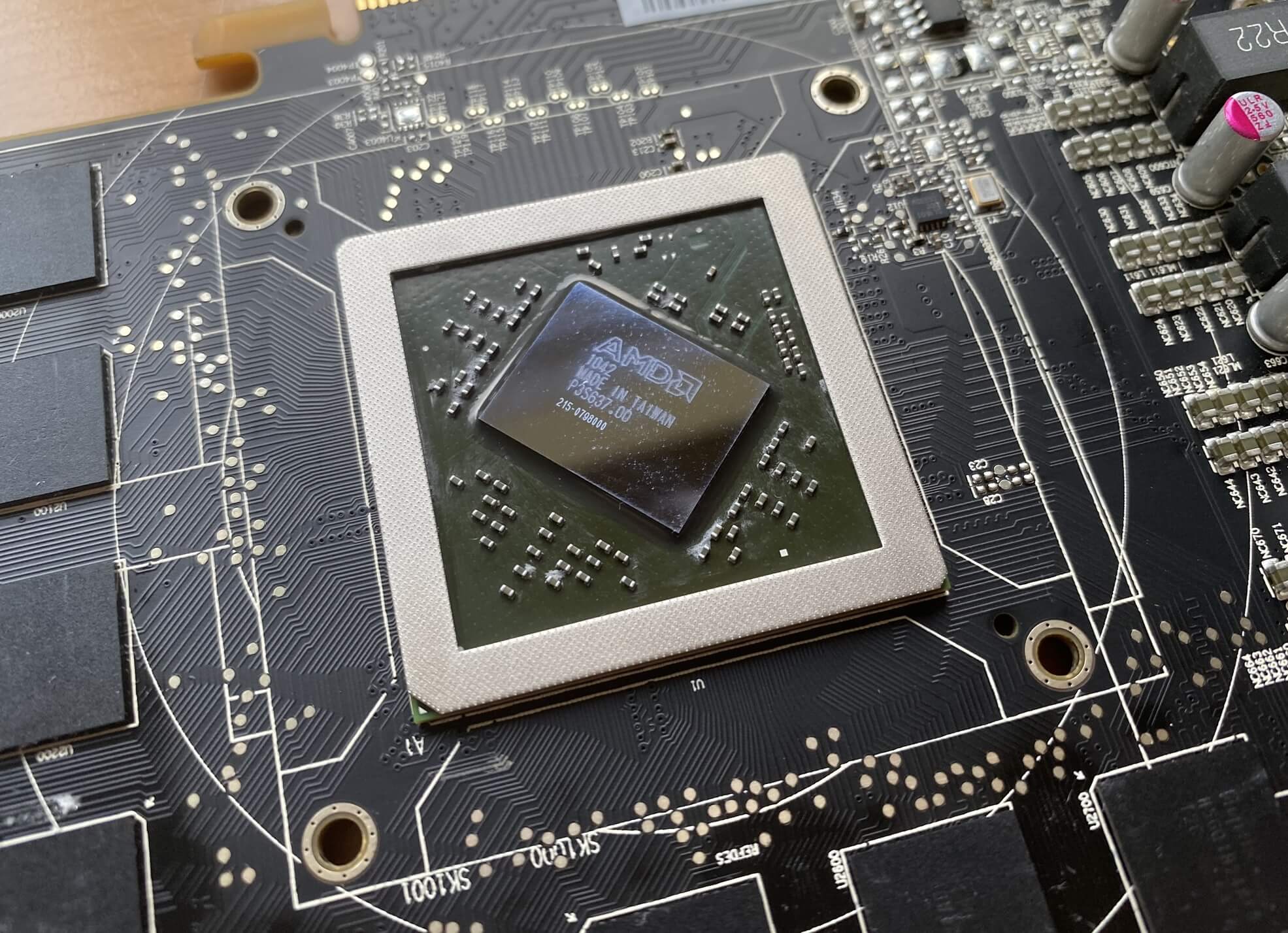

Pas que ça compte aujourd'hui. Tous les GPU ont à peu près la même structure à l'intérieur de la puce que nous voyons:

Ce processeur a été conçu par AMD et fabriqué par TSMC; il a des noms de code tels que TeraScale 2 pour l'architecture globale, et Barts XT pour la variante à puce. Emballé dans 0,4 pouces carrés (255 mm2) de silicium sont 1,7 milliard transistors.

Ce nombre ahurissant de commutateurs électroniques constitue les différents ASIC (circuits intégrés spécifiques à l'application) que les GPU arborent. Certains ne font que définir des opérations mathématiques, comme multiplier et ajouter deux nombres; d'autres lisent des valeurs en mémoire et les convertissent en signal numérique pour un moniteur.

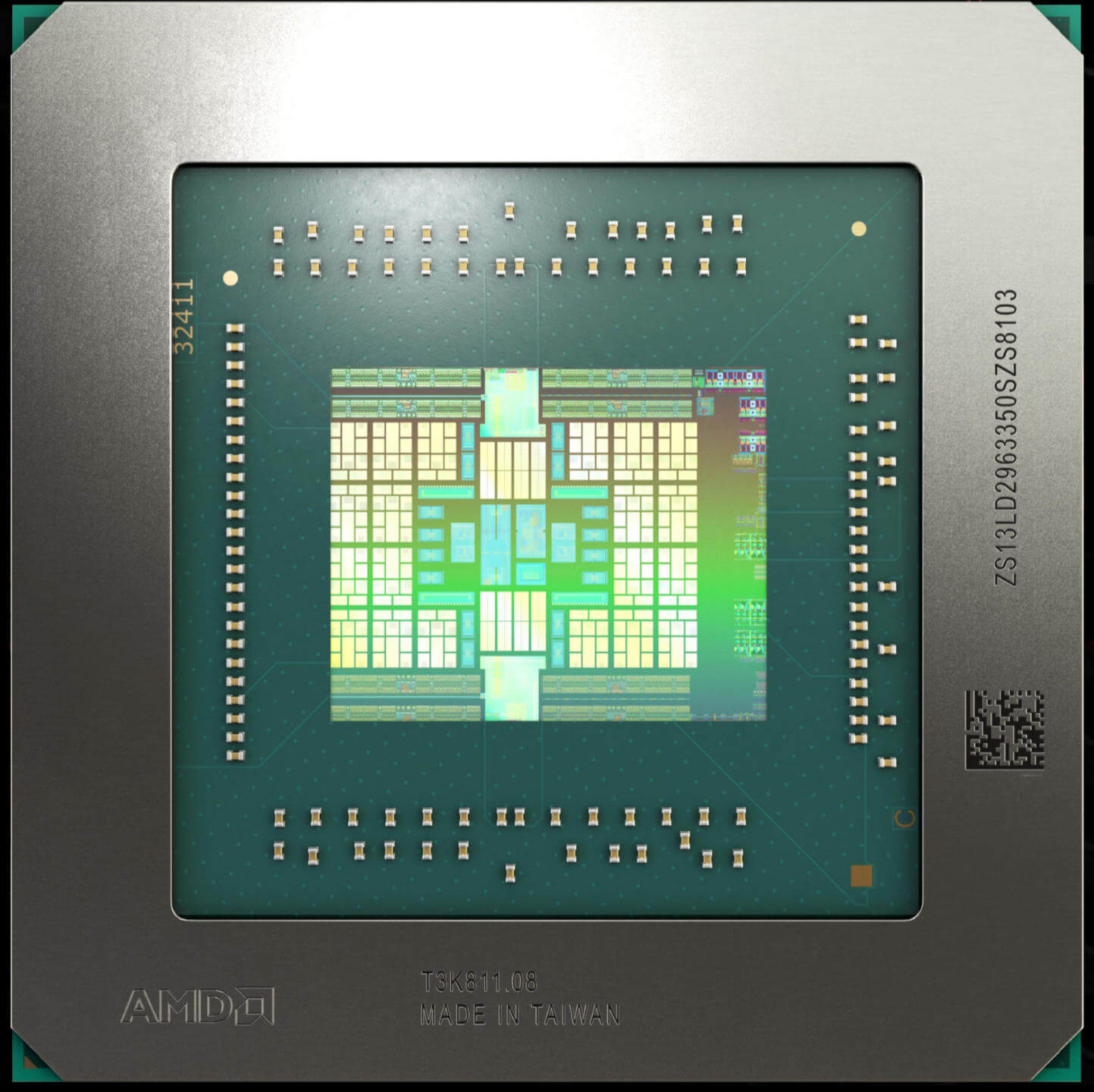

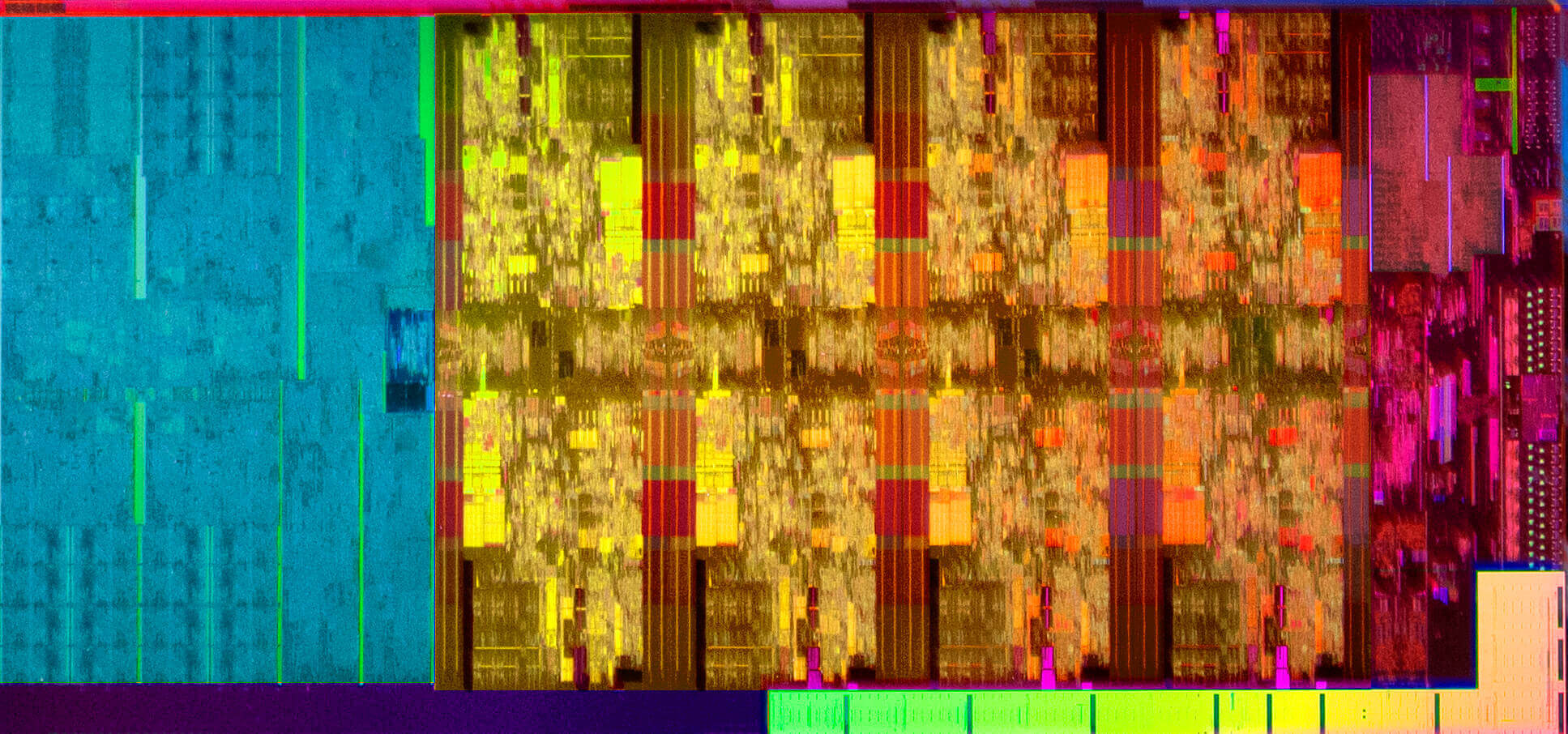

Les GPU sont conçus pour beaucoup de choses en même temps, donc un grand pourcentage de la structure de la puce se compose de blocs répétitifs d'unités logiques. Vous pouvez les voir clairement dans l'image suivante (fortement traitée) de la gamme actuelle de GPU Navi d'AMD:

Voyez comment il y a 20 copies du même motif? Ce sont les principales unités de calcul de la puce et effectuent la majeure partie du travail pour créer des graphiques 3D dans les jeux. La bande qui s'étend à peu près au milieu est principalement cache – mémoire interne haute vitesse pour stocker les instructions et les données.

Sur les bords, en haut et en bas, se trouvent les ASIC qui gèrent les communications avec les puces RAM de la carte, et à l'extrême droite du processeur se trouvent des circuits pour parler au reste de l'ordinateur et encoder / décoder les signaux vidéo.

Vous pouvez vous renseigner sur les dernières conceptions de GPU d'AMD et de Nvidia, ainsi que d'Intel, si vous voulez mieux comprendre les tripes du GPU. Pour l'instant, nous allons simplement souligner que si vous voulez jouer aux derniers jeux ou explorer le code d'apprentissage automatique, vous aurez besoin d'un processeur graphique.

Mais tous les GPU ne sont pas fournis sur une carte de circuit imprimé que vous bloquez dans votre PC de bureau. Beaucoup de CPU ont un petit processeur graphique intégré; ci-dessous est une prise de vue Intel (d'où la nature plutôt floue) d'un Core i7-9900K.

La coloration a été ajoutée pour identifier différentes zones, où la section bleue à gauche est la intégré GPU. Comme vous pouvez le voir, il occupe environ un tiers de la puce entière, mais comme Intel ne déclare jamais publiquement le nombre de transistors pour ses puces, il est difficile de dire à quel point ce GPU est « gros ''.

Nous pouvons cependant estimer et comparer les GPU les plus grands et les plus petits qu'AMD, Intel et Nvidia proposent parmi les dernières architectures:

| Fabricant | AMD | Intel | Nvidia | |||

| Architecture | RNDA | Gen 9.5 | Turing | |||

| Puce / modèle | Navi 10 | Navi 14 | GT3e | GT1 | TU102 | TU117 |

| Nombre de transistors (milliards) | 10,3 | 6,4 | Certains | Moins | 18,6 | 4.7 |

| Taille de la matrice (mm2) | 251 | 158 | Environ 80? | 30 ou plus | 754 | 200 |

Les GPU Navi sont construits sur un nœud de processus TMSC 7nm, comparé aux 14nm d'Intel et à un nœud 16nm spécialement raffiné que TMSC propose pour Nvidia (il s'appelle 12FFN); cela signifie que vous ne pouvez pas comparer directement entre eux, mais une chose est sûre – les GPU ont beaucoup de transistors en eux!

Pour donner une idée de la perspective, ce processeur Rage IIC de 21 ans montré plus tôt a 5 millions de transistors emballés dans une taille de puce de 39 mm2. La plus petite puce Navi d'AMD possède 1 280 fois plus de transistors dans une zone qui n'est que 4 fois plus grande – c'est à quoi ressemblent 2 décennies de progrès.

Un éléphant n'oublie jamais

Comme toutes les cartes graphiques pour PC de bureau, la nôtre a un tas de puces de mémoire soudées sur la carte de circuit imprimé. Ceci est utilisé pour stocker toutes les données graphiques nécessaires pour créer les images que nous voyons dans les jeux, et est presque toujours un type de DRAM spécialement conçu pour les applications graphiques.

Initialement appelé DDR SGRAM (mémoire à accès aléatoire de graphiques synchrones à double débit) lorsqu'elle est apparue sur le marché, elle porte aujourd'hui le nom abrégé de GDDR.

Notre échantillon comprend 8 modules Hynix H5GQ1H23AFR GDDR5 SDRAM, fonctionnant à 1,05 GHz. Ce type de mémoire se trouve encore sur de nombreuses cartes disponibles aujourd'hui, bien que l'industrie se dirige généralement vers la version la plus récente, GDDR6.

Les GDDR5 et 6 fonctionnent de manière similaire: une horloge de base (celle mentionnée ci-dessus) est utilisée pour chronométrer l'émission des instructions et des transferts de données. Un système séparé est ensuite utilisé pour décaler les bits vers et depuis les modules de mémoire, et cela se fait comme un transfert de bloc en interne. Dans le cas de GDDR5, 8 x 32 bits sont traités pour chaque accès en lecture / écriture, tandis que GDDR6 est le double de cette valeur.

Ce bloc est défini comme un flux séquentiel, 32 bits à la fois, à une vitesse qui est à nouveau contrôlée par un système d'horloge différent. Dans GDDR5, cela fonctionne à deux fois la vitesse de l'horloge de base et les données sont décalées deux fois par tick de cette horloge particulière.

Ainsi, dans notre Radeon HD 6870, avec 8 puces Hynix au total, le GPU peut transférer jusqu'à 2 (transfert par tick) x 2 (double horloge de données) x 1,05 (horloge de base) x 8 (puces) x 32 (largeur du flux) ) = 1075,2 Gbits par seconde ou 134,4 Mo / s. Ce chiffre calculé est appelé bande passante mémoire théorique de la carte graphique, et en général, vous voulez que ce soit aussi élevé que possible. GDDR6 a deux modèles de taux de transfert, normal double taux et un quad modèle (double le double!).

Toutes les cartes graphiques n'utilisent pas GDDR5 / 6. Les modèles bas de gamme s'appuient souvent sur des SDRAM DDR3 plus anciennes (comme l'exemple refroidi passivement que nous avons montré précédemment), qui n'est pas conçu spécifiquement pour les applications graphiques. Étant donné que le GPU sur ces cartes sera assez faible, il n'y a aucune perte dans l'utilisation de la mémoire générique.

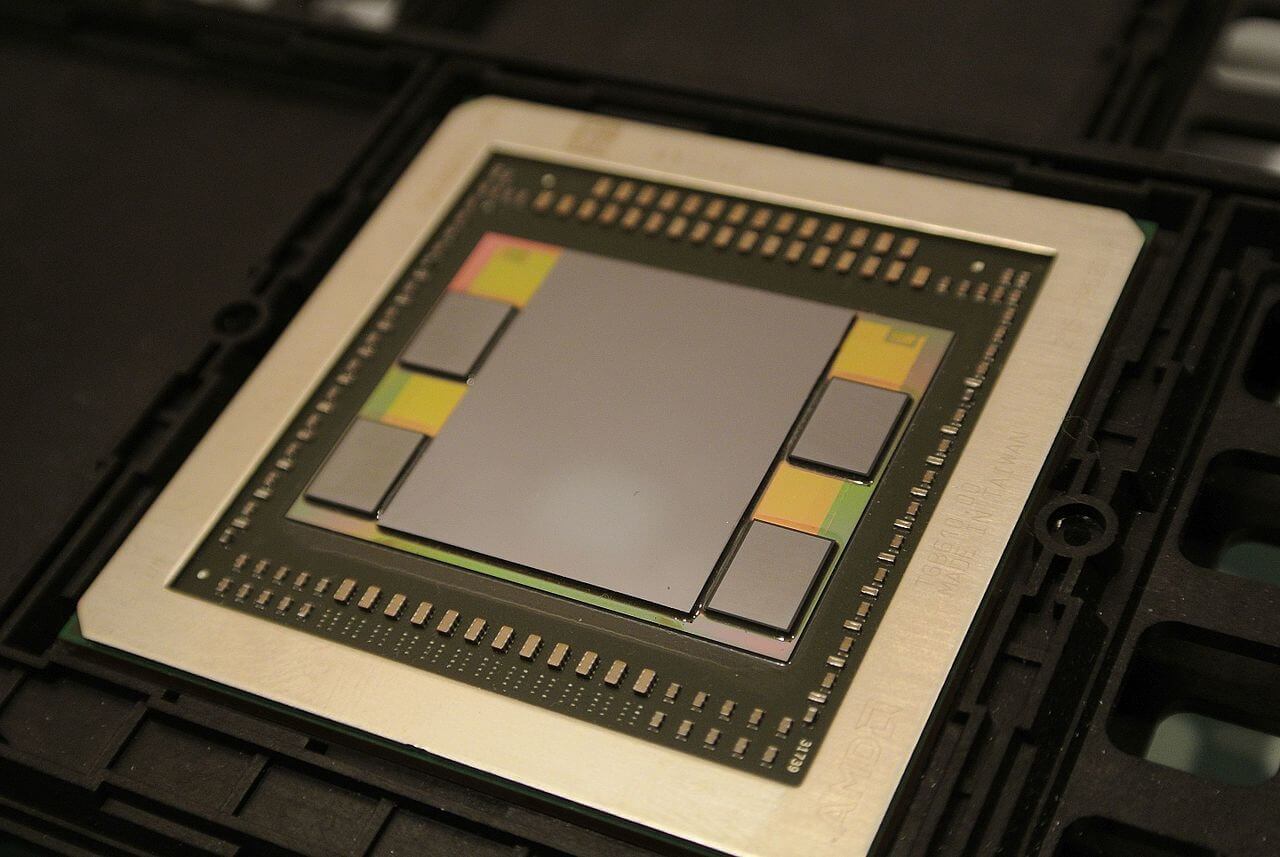

Nvidia a essayé le GDDR5X pendant un certain temps – il a le même débit quadruple que le GDDR6, mais ne peut pas être cadencé aussi rapidement – et AMD a utilisé HBM (Mémoire à large bande passante) allumé et éteint pendant quelques années, comme la Radeon R9 Fury X, la Radeon VII et d'autres. Toutes les versions de HBM offrent d'énormes quantités de bande passante, mais leur fabrication est plus coûteuse que les modules GDDR.

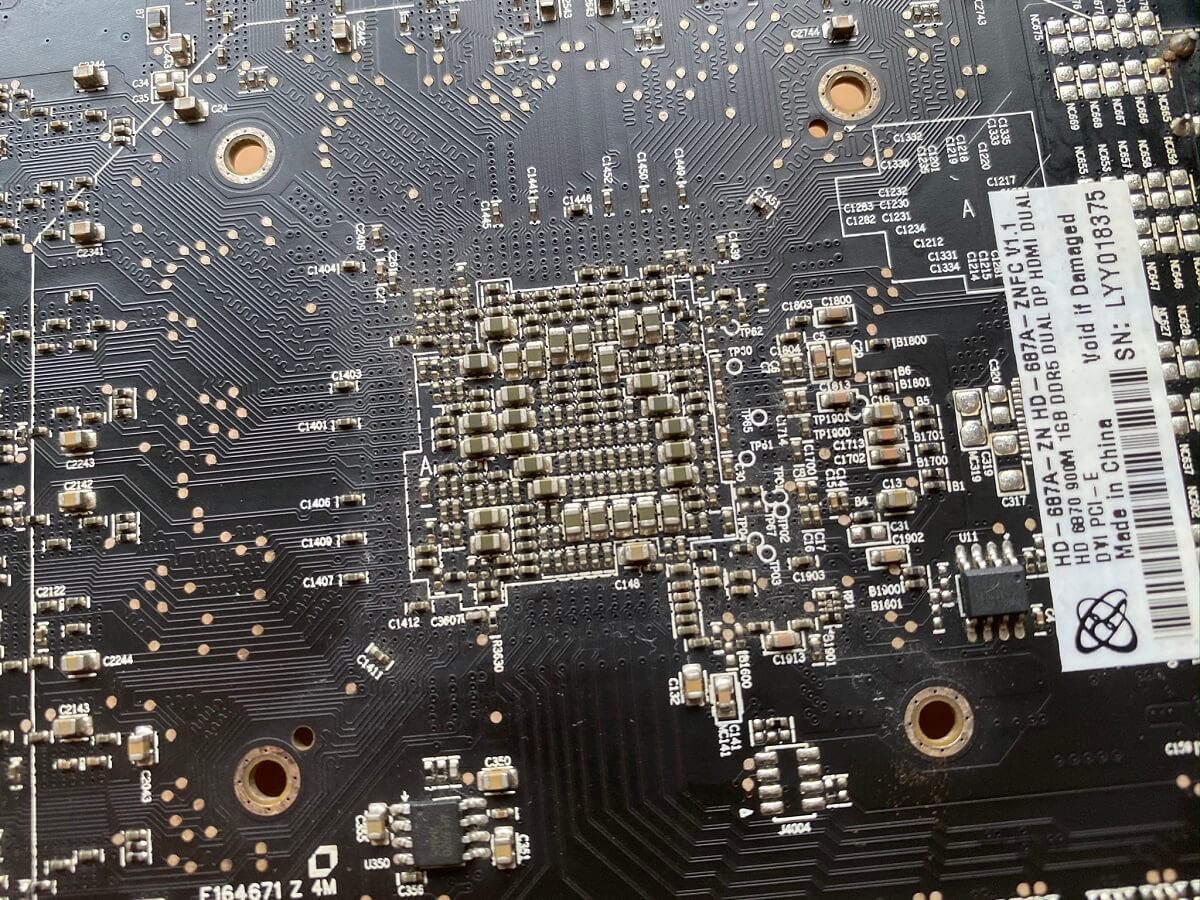

Les puces mémoire doivent être directement câblées au GPU lui-même, pour assurer les meilleures performances possibles, et parfois cela signifie que le traces (le câblage électrique sur la carte de circuit imprimé) peut être un peu bizarre.

Remarquez comment certaines traces sont droites, tandis que d'autres suivent un chemin bancal? Cela permet de garantir que chaque signal électrique, entre le GPU et le module de mémoire, se déplace le long d'un chemin exactement de la même longueur; cela aide à éviter tout événement indésirable.

La quantité de mémoire sur une carte graphique a beaucoup changé depuis les premiers jours des GPU.

Le chargeur 3D ATi Rage que nous avons montré précédemment ne contenait que 4 Mo de EDO DRAM. Aujourd'hui, c'est un mille fois plus grande, avec 4 à 6 Go étant la norme attendue (les modèles haut de gamme doublent souvent cela à nouveau). Étant donné que les ordinateurs portables et les PC de bureau se sont récemment éloignés d'avoir 8 Go de RAM en standard, les cartes graphiques sont de véritables éléphants en termes de quantité de mémoire!

La mémoire GDDR ultra rapide est utilisée car les GPU doivent lire et écrire de nombreuses données, en parallèle, tout le temps où elles fonctionnent; les GPU intégrés ne viennent souvent pas avec ce qu'on appelle local mémoire, et à la place, doivent compter sur la RAM du système. L'accès à cela est beaucoup plus lent que d'avoir des gigaoctets de GDDR5 juste à côté du processeur graphique, mais ces types de GPU ne sont pas assez puissants pour en avoir vraiment besoin.

Je demande de l'énergie et beaucoup d'elle

Comme tout appareil dans un ordinateur, les cartes graphiques ont besoin d'une alimentation électrique pour fonctionner. La quantité dont ils ont besoin dépend principalement du GPU de la carte, car les modules de mémoire n'ont besoin que de quelques watts chacun.

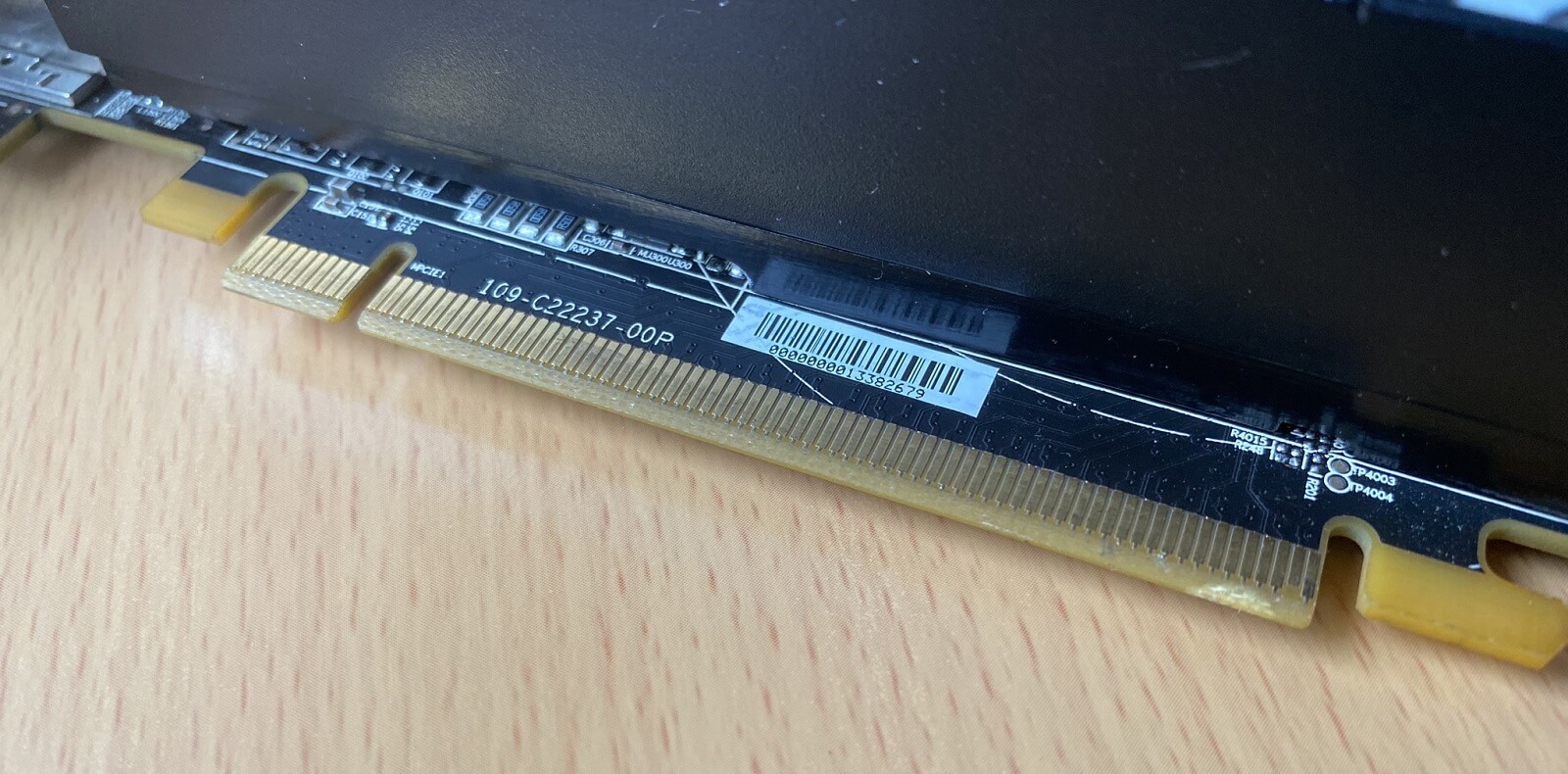

La première façon dont la carte peut obtenir son alimentation est emplacement d'extension il est branché et pratiquement tous les PC de bureau utilisent aujourd'hui une connexion PCI Express.

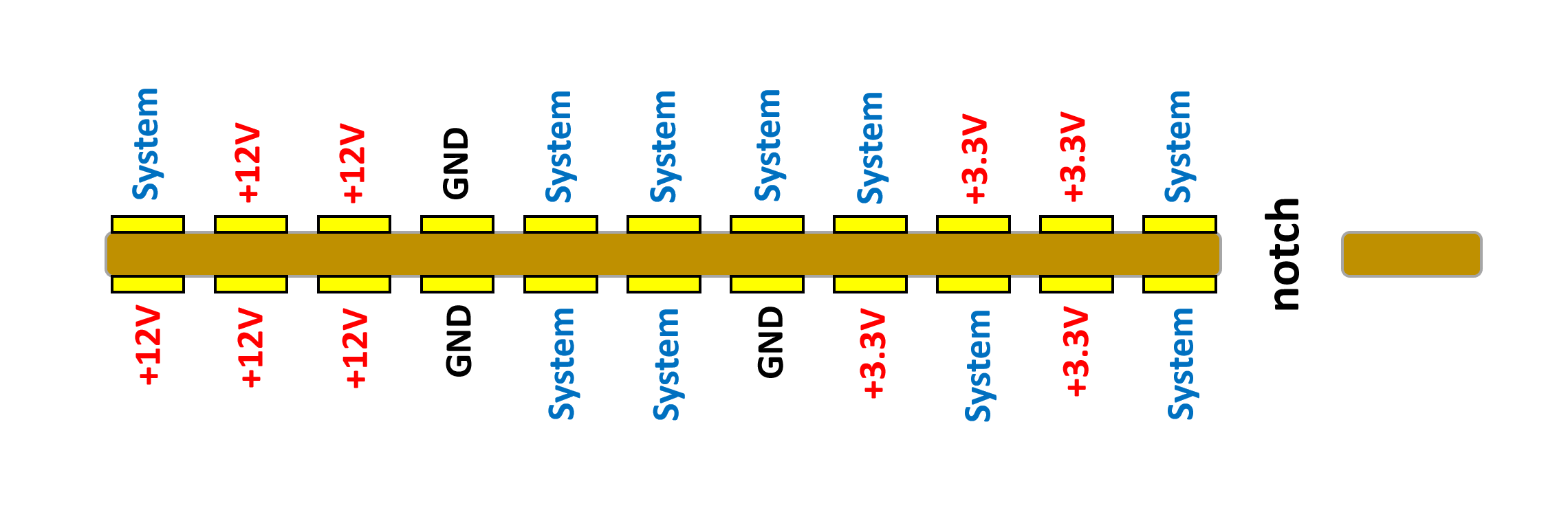

Dans l'image ci-dessus, l'alimentation est fournie par la plus petite bande de broches à gauche – la longue bande à droite est purement pour les instructions et le transfert de données. Il y a 22 broches, 11 par côté, dans la bande courte, mais toutes ces broches ne sont pas là pour alimenter la carte.

Près de la moitié des 22 broches sont destinées aux tâches générales du système – la vérification de la carte est correcte, de simples instructions de mise sous / hors tension, etc. La dernière spécification PCI Express limite la quantité de courant pouvant être tirée, au total, sur les deux ensembles de lignes de tension. Pour les cartes graphiques modernes, c'est 3 ampères sur les lignes + 3,3 V et 5,5 ampères sur le +12; cela fournit un total de (3 x 3,3) + (5,5 x 12) = 75,9 watts de puissance.

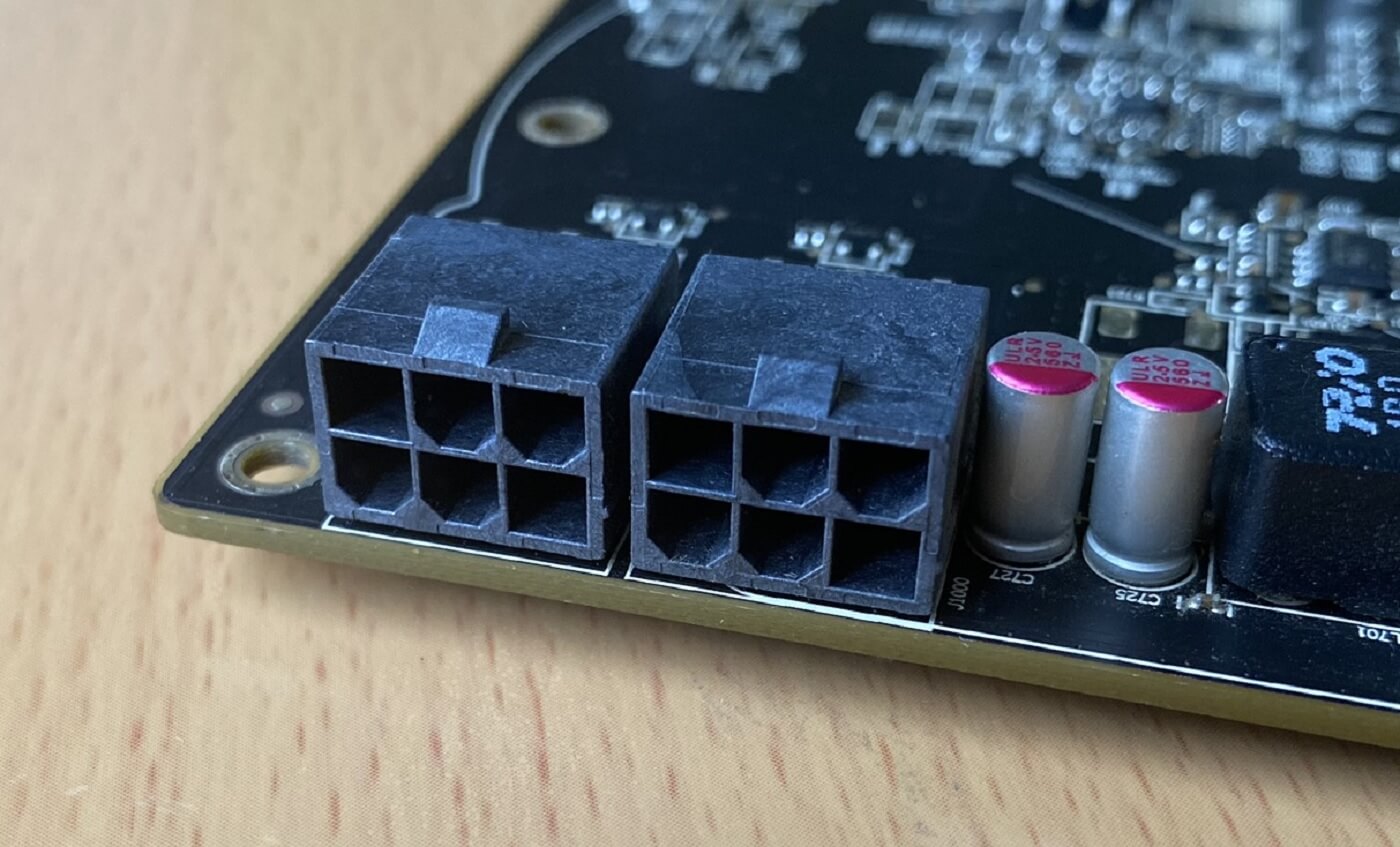

Que se passe-t-il si votre carte a besoin de plus que cela? Par exemple, notre échantillon Radeon HD 6870 a besoin d'au moins 150 W – le double de ce que nous pouvons obtenir du connecteur. Dans ces cas, la spécification fournit un format qui peut être suivi par les fabricants sous la forme de lignes supplémentaires + 12V. Le format est disponible en deux types: un connecteur à 6 broches et un connecteur à 8 broches.

Les deux formats fournissent trois autres lignes de tension +12; la différence entre eux réside dans le nombre de lignes de masse: trois pour la version 6 broches et cinq pour la version 8 broches. Ce dernier permet de tirer plus de courant à travers le connecteur, c'est pourquoi la 6 broches ne fournit qu'une puissance supplémentaire de 75 W, tandis que le plus grand format pousse cela jusqu'à 150 W.

Notre carte a deux connecteurs à 6 broches, donc avec l'emplacement d'extension PCI Express, elle peut prendre 75 + (2 x 75) = 225 watts de puissance; largement suffisant pour les besoins de ce modèle.

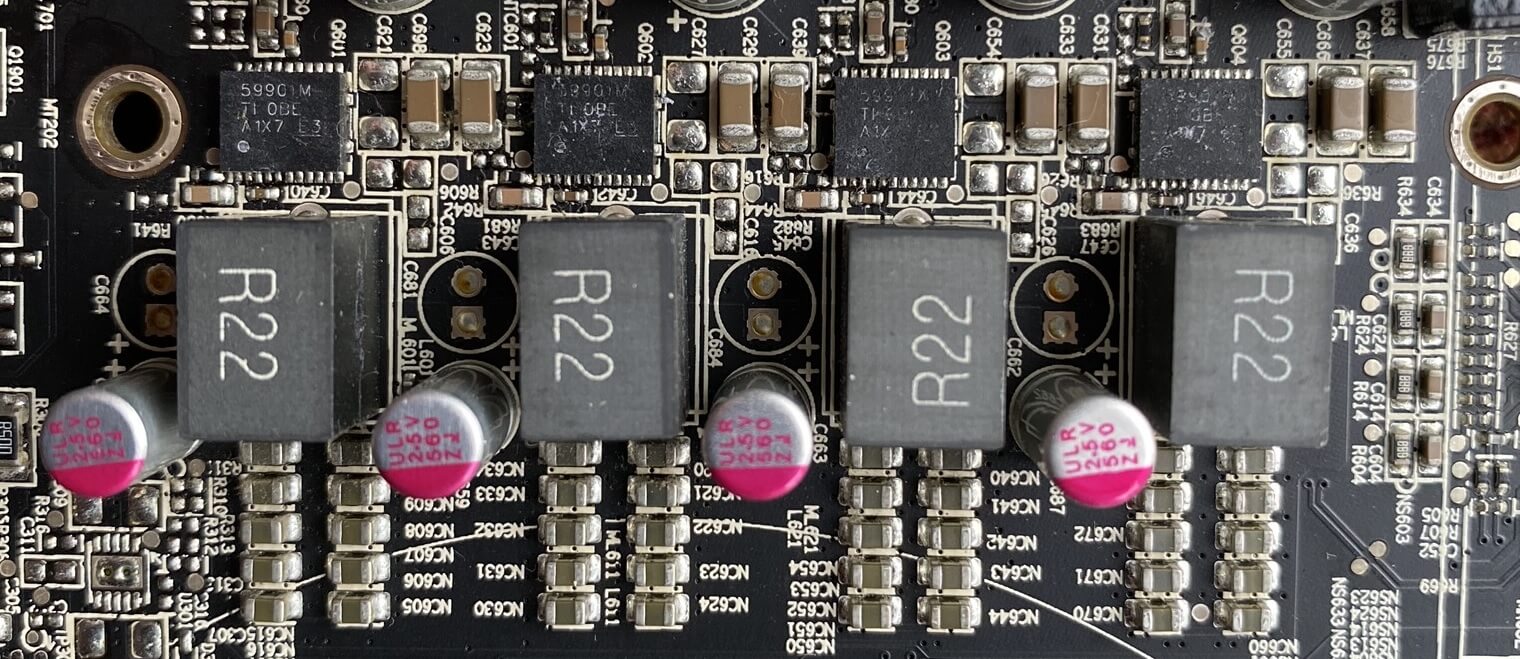

Le prochain problème à gérer est le fait que les puces GPU et mémoire ne fonctionnent pas sur des tensions +3,3 ou +12: les puces GDDR5 sont à 1,35 V et le GPU AMD nécessite 1,172 V. Cela signifie que les tensions d'alimentation doivent être abaissées et soigneusement réglementées, et cette tâche est gérée par modules de régulateur de tension (VRM, pour faire court).

Nous avons vu des VRM similaires lorsque nous avons examiné les cartes mères et les blocs d'alimentation, et c'est le mécanisme standard utilisé aujourd'hui. Ils obtiennent également un peu de pain grillé quand ils travaillent loin, c'est pourquoi ils sont aussi (ou j'espère aussi!) enterré sous un dissipateur thermique pour les maintenir dans leur plage de température de fonctionnement.

Tout comme avec la carte mère et les CPU, le nombre et le type (lire: qualité) des VRM ont un impact sur la stabilité du GPU, lorsqu'il est overclocké. Cela inclut la qualité de la puce de contrôle de puissance globale.

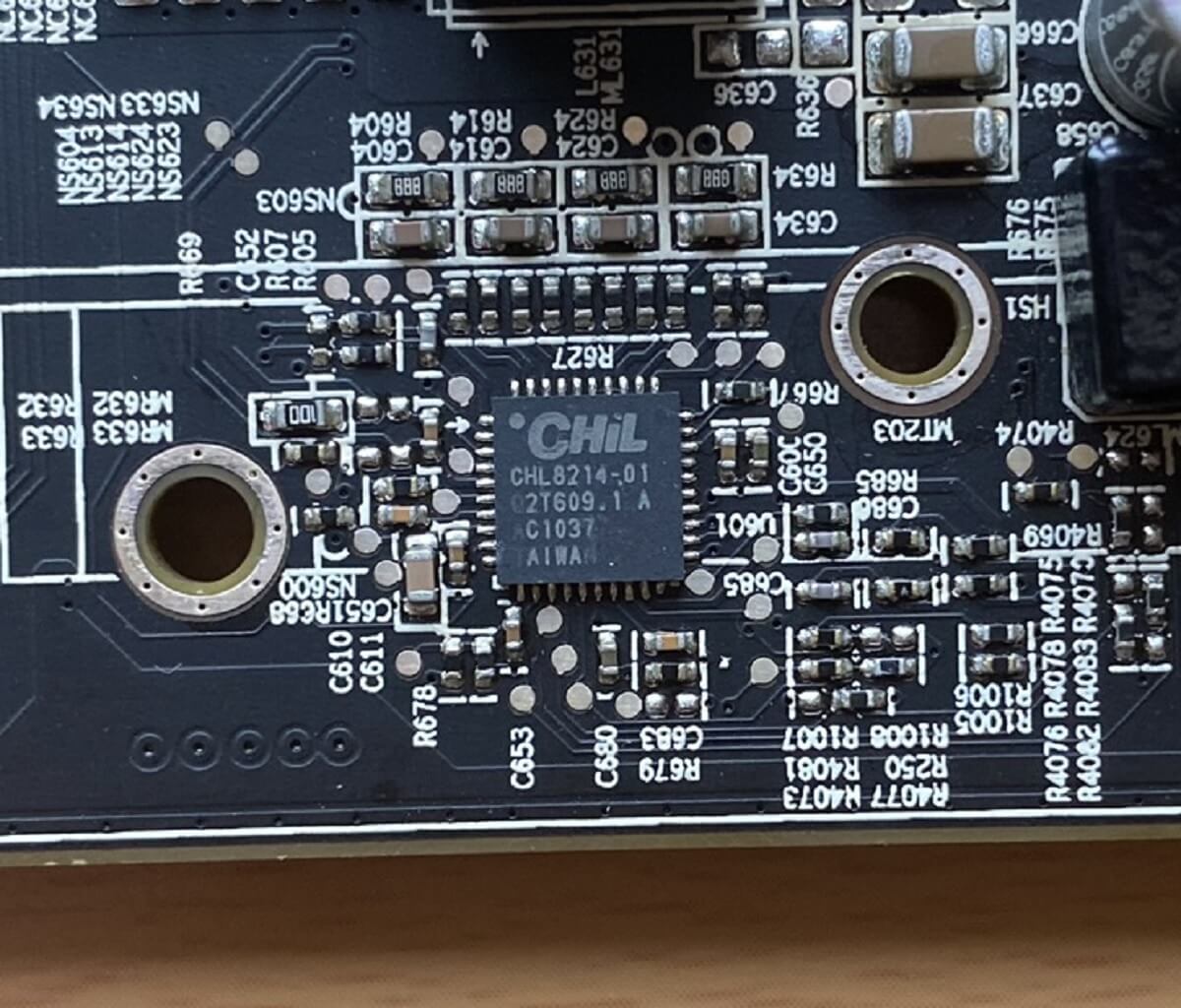

Cette Radeon HD 6870 vieille de dix ans utilise un CHIL CHL821401, qui est un contrôleur PWM 4 + 1 phase (afin qu'il puisse gérer les 4 VRM vus ci-dessus, plus un autre système de régulation de tension); il peut également suivre les températures et la quantité de courant consommée. Il peut régler les VRM pour qu'ils changent entre l'une des trois tensions différentes, une fonction qui est largement utilisée dans les GPU modernes car ils passent à une tension plus faible au ralenti, pour économiser de l'énergie et réduire la chaleur / le bruit.

Plus le GPU nécessite de puissance, plus il y a de VRM et meilleur sera le contrôleur PWM. Par exemple, dans notre examen de la GeForce RTX 2080 de Nvidia, nous avons retiré le système de refroidissement pour examiner la carte de circuit imprimé et les composants:

Vous pouvez voir une batterie de Dix VRM descendant sur toute la hauteur de la carte, à droite du GPU; les goûts d'EVGA proposent des cartes graphiques avec presque le double de ce nombre! Ces cartes sont bien entendu conçues pour être fortement overclockées et lorsqu'elles le sont, la consommation électrique de la carte graphique sera bien supérieure à 300W.

Heureusement, toutes les cartes graphiques n'ont pas des besoins énergétiques insensés. Les meilleurs produits de milieu de gamme actuellement disponibles se situent entre 125 et 175 W, ce qui correspond à peu près au même niveau que notre Radeon HD 6870.

Les tenants et aboutissants d'une carte graphique

Jusqu'à présent, nous avons examiné les composants électroniques sur la carte de circuit imprimé et la façon dont l'alimentation leur est fournie. Il est temps de voir comment les instructions et les données sont envoyées au GPU et comment il envoie ensuite ses résultats à un moniteur. En termes, les connexions d'entrée / sortie (E / S).

Les instructions et les données sont envoyées via le connecteur PCI Express que nous avons vu précédemment. Tout se fait à travers les broches sur la longue section du connecteur de fente. La totalité de la transmettre les broches sont d'un côté, et la recevoir broches de l'autre; ils vont toujours dans un groupe de 4, chaque ensemble étant appelé voie.

En effet, la communication PCI Express se fait à l'aide de signalisation différentielle, donc deux broches gèrent les instructions / données et les 2 autres broches sont pour la mise à la terre. Presque toutes les cartes graphiques utilisent 16 voies (c'est-à-dire PCI Express x16) et chacune peut transférer 8 bits de données, à un taux monstre de 8 GHz.

Ajoutez les 16 voies ensemble et vous avez un taux de transfert potentiel de 16 Go / s – c'est en fait moins que cela, car la signalisation PCI Express utilise un système de codage qui sacrifie certains bits (environ 2%) pour la qualité du signal. La toute dernière version de la spécification PCI Express, 4.0, double cela à 32 Go / s; il y a deux autres spécifications en cours de développement qui multiplient encore par 2 respectivement.

Certaines cartes graphiques, comme notre HD 6870, ont un connecteur supplémentaire, comme illustré ci-dessous:

Cela vous permet de coupler deux cartes ou plus ensemble, afin qu'elles puissent partager rapidement des données lorsque vous travaillez en tant que système multi-GPU. Chaque fournisseur a son propre nom: AMD l'appelle CrossFire, Nvidia fait SLI. Le premier n'utilise plus ce connecteur et fait simplement tout à travers le slot PCI Express.

Si vous regardez en arrière sur cette page l'image de la GeForce RTX 2080, vous verrez qu'il existe deux de ces connexions multi-GPU – il s'agit de la version la plus récente de Nvidia, appelée NVLink. Il est principalement destiné aux graphiques professionnels et aux cartes de calcul, plutôt qu'aux cartes de jeu générales. Malgré les efforts d'AMD et de Nvidia pour faire en sorte que les systèmes multi-GPU soient largement utilisés, cela n'a pas été un succès excessif, et ces jours-ci, il vaut mieux obtenir le meilleur GPU unique que vous pouvez vous permettre.

Tous les graphiques de PC de bureau auront également au moins une méthode pour y connecter un moniteur, mais la plupart en ont plusieurs. Ils le font parce que les moniteurs sont disponibles dans toutes sortes de modèles et de budgets, ce qui signifie que la carte devra en prendre en charge autant que possible.

Notre Radeon dépouillé dispose de 5 sorties de ce type:

Regarde:

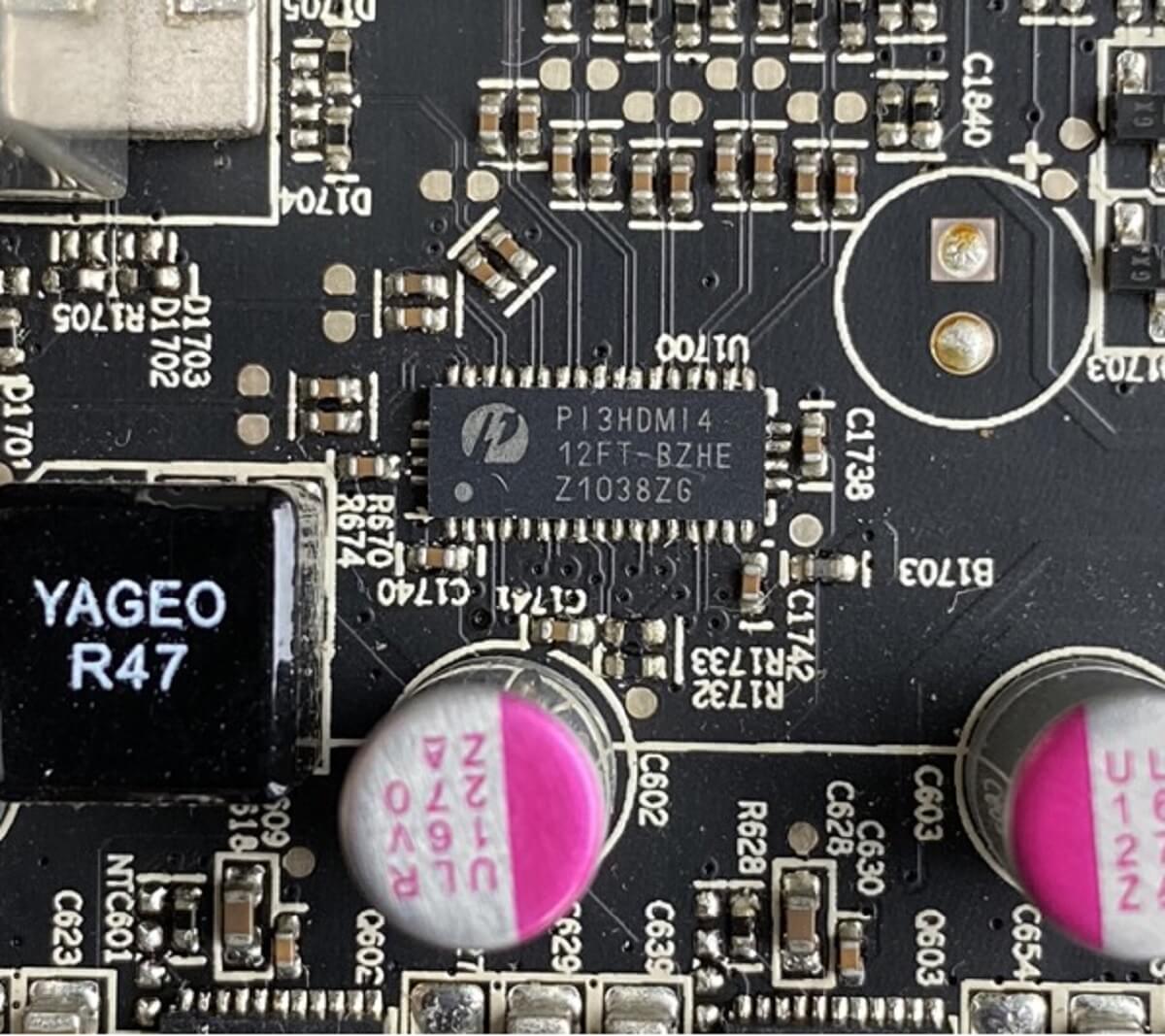

Prenant en charge autant de types de moniteurs que possible, le fait d'avoir plusieurs prises de sortie signifie également que vous pouvez connecter plusieurs écrans à la carte graphique. Une partie de ce jonglage de moniteur est gérée par le GPU lui-même, mais parfois une puce supplémentaire est nécessaire pour un peu de signal tour de main. Dans notre carte, il dispose d'un commutateur HDMI Pericom P13HDMI4 pour effectuer certaines de ces opérations:

Cette toute petite puce convertit les données HDMI, qui contiennent des flux vidéo et audio numériques, en signaux d'image uniquement pour les prises DVI. La spécification de ces connexions est beaucoup plus importante de nos jours, en raison des changements dans la façon dont nous utilisons nos moniteurs.

L'essor de l'e-sport a poussé l'industrie des moniteurs vers de plus en plus taux de rafraîchissement (le nombre de fois par seconde que le moniteur redessine l'image sur l'écran) – Il y a 10 ans, la grande majorité des moniteurs étaient plafonnés à 60 ou 75 Hz. Aujourd'hui, vous pouvez obtenir des écrans 1080p pouvant fonctionner à 240 Hz.

Les cartes graphiques modernes sont également très puissantes, et beaucoup sont capables de fonctionner à des résolutions élevées, telles que 1440p et 4K, ou offrent plage dynamique élevée (HDR). Et pour ajouter à la longue liste de demandes, de nombreux écrans prennent en charge variable technologie de taux de rafraîchissement (VRR); un système qui empêche le moniteur d'essayer de mettre à jour son image, tandis que la carte graphique la dessine encore.

Il existe des formats ouverts et propriétaires pour VRR:

Pour pouvoir utiliser ces fonctionnalités (par exemple, hautes résolutions, taux de rafraîchissement élevés et variables, HDR), il y a 3 questions auxquelles il faut répondre: le moniteur le prend-il en charge? Le GPU le prend-il en charge? La carte graphique utilise-t-elle des connecteurs de sortie capables de le faire?

Si vous partez et achetez l'une des dernières cartes AMD (Navi) ou Nvidia (Turing), voici les systèmes de sortie pris en charge:

| Fabricant | AMD | Nvidia |

| DVI | Numérique à double liaison | Numérique à double liaison |

| 1600p @ 60Hz, 1080p @ 144Hz | 1600p @ 60Hz, 1080p @ 144Hz | |

| DisplayPort | 1.4a (DSC 1.2) | 1.4a (DSC 1.2) |

| 4K HDR à 240 Hz, 8K HDR à 60 Hz | 4K HDR à 144 Hz, 8K HDR à 60 Hz | |

| HDMI | 2.0b | 2.0b |

| 4K à 60 Hz, 1080p à 240 Hz | 4K à 60 Hz, 1080p à 240 Hz | |

| VRR | Synchronisation adaptative DP, VRR HDMI, FreeSync | Synchronisation adaptative DP, VRR HDMI, G-Sync |

Cependant, les chiffres ci-dessus ne donnent pas une image complète. Bien sûr, vous pouvez déclencher des images 4K à plus de 200 Hz via la connexion DisplayPort au moniteur, mais ce ne sera pas avec les données brutes dans la RAM de la carte graphique. La sortie ne peut envoyer que tant de bits par seconde, et pour des résolutions et des taux de rafraîchissement vraiment élevés, ce n'est pas suffisant.

Heureusement, la compression des données ou le sous-échantillonnage de la chrominance (un processus où la quantité d'informations sur les couleurs envoyées est réduite) peut être utilisé pour alléger la charge sur le système d'affichage. C'est là que de légères différences dans les modèles de cartes graphiques peuvent faire la différence: on peut utiliser un système de compression standard, un système propriétaire ou une variante de sous-échantillonnage de chrominance.

Il y a 20 ans, il y avait de grandes différences dans les sorties vidéo des cartes graphiques, et vous étiez souvent obligé de faire le choix de sacrifier la qualité pour la vitesse. Pas si aujourd'hui … phew!

Tout ça pour des graphismes?

Cela peut sembler un peu étrange que tant de complexité et de coût soient nécessaires pour simplement dessiner les images que nous voyons, lorsque nous jouons à Call of Mario: Deathduty Battleyard. Revenez au début de cet article et regardez à nouveau cette carte graphique ATi 3D Charger. Ce GPU pourrait cracher jusqu'à 1 million de triangles et colorier en 25 millions de pixels en une seconde. Pour une carte au même prix aujourd'hui, ces chiffres ont été multipliés par plus de 2 000.

Avons-nous vraiment besoin de ce genre de performance? La réponse est oui: en partie parce que les joueurs d'aujourd'hui ont des attentes beaucoup plus élevées en matière de graphisme, mais aussi parce que la création de visuels 3D réalistes, en temps réel, est super difficile. Donc, lorsque vous piratez des dragons, que vous faites un zoom sur l'Eau Rouge dans Raidillon ou que vous faites face à une Zerg Rush, épargnez quelques secondes pour votre carte graphique – vous en demandez beaucoup!

Mais les GPU peuvent faire plus que simplement traiter des images. Ces dernières années, l'utilisation de ces processeurs dans les superordinateurs a explosé pour l'apprentissage automatique complexe et l'intelligence artificielle. Le cryptomining est devenu incroyablement populaire en 2018, et les cartes graphiques étaient idéales pour un tel travail.

Le mot à la mode ici est calculer –– un domaine normalement dans le domaine du CPU, le GPU a désormais pris le relais dans des domaines spécifiques qui nécessitent des calculs parallèles massifs, le tout fait en utilisant des valeurs de données de haute précision. AMD et Nvidia fabriquent des produits destinés à ce marché, et ils sont presque toujours équipés des processeurs graphiques les plus grands et les plus chers.

En parlant de cela, vous êtes-vous déjà demandé à quoi ressemblent les tripes d'une carte graphique à 2 500 $? Les joueurs Nexus devaient aussi être curieux, car ils sont allés de l'avant et en ont séparé un:

Si vous êtes tenté de faire de même avec le vôtre, faites attention! N'oubliez pas que tous ces composants électroniques sont assez fragiles et nous doutons que tout détaillant les remplacera si vous gâchez les choses.

Donc, que votre carte graphique coûte 20 $, 200 $ ou 2000 $, elles sont toutes fondamentalement de la même conception: un processeur hautement spécialisé, sur une carte de circuit imprimé remplie de puces de support et d'autres composants électroniques. Comparé à notre dissection d'une carte mère et d'un bloc d'alimentation, il y a moins de choses à séparer, mais ce qu'il y a est assez génial.

Et donc nous disons au revoir aux restes de notre carte graphique Radeon HD 6870. Les morceaux iront dans une boîte et seront stockés dans une armoire. Une fin quelque peu ignominieuse à une telle merveille de la technologie informatique, qui nous a impressionnés en créant des images incroyables, toutes rendues possibles grâce à l'utilisation de milliards de transistors microscopiques.

Si vous avez des questions sur les GPU en général ou celui que vous utilisez actuellement sur votre ordinateur, envoyez-les nous dans la section commentaires ci-dessous. Restez à l'écoute pour encore plus de fonctionnalités de la série anatomie.