AMD est l'un des plus anciens concepteurs de microprocesseurs à grande échelle et fait l'objet d'un débat polarisant parmi les passionnés de technologie depuis près de 50 ans. Son histoire en fait un conte passionnant – rempli de succès héroïques, d'erreurs téméraires et d'un rasage de près avec rack et ruine. Là où d'autres entreprises de semi-conducteurs sont venues et ont disparu, AMD a traversé de nombreuses tempêtes et a mené de nombreuses batailles, dans les salles de conférence, les tribunaux et les magasins.

Dans cette fonctionnalité, nous reviendrons sur le passé de la société, examinerons les rebondissements sur le chemin du présent et nous demanderons ce qui nous attend pour ce vétéran de la Silicon Valley.

L'ascension vers la gloire et la fortune

Pour commencer notre histoire, nous devons faire reculer les années et nous diriger vers l'Amérique et la fin des années 50. En plein essor après les années difficiles de la Seconde Guerre mondiale, c'était le moment et l'endroit où aller si vous vouliez faire l'expérience de l'avant-garde de l'innovation technologique.

Des sociétés telles que Bell Laboratories, Texas Instruments et Fairchild Semiconductor ont employé les meilleurs ingénieurs et ont produit de nombreuses premières: le transistor de jonction bipolaire, le circuit intégré et le MOSFET (transistor à effet de champ à semi-conducteur à oxyde métallique).

Ces jeunes techniciens voulaient rechercher et développer des produits toujours plus excitants, mais avec des cadres supérieurs prudents conscients des temps où le monde était effrayant et instable, la frustration des ingénieurs crée le désir de se lancer seul.

Ainsi, en 1968, deux employés de Fairchild Semiconductor, Robert Noyce et Gordon Moore, ont quitté l'entreprise et ont tracé leur propre chemin. N M Electronics a ouvert ses portes cet été-là, pour être renommé quelques semaines plus tard Électronique intégrée – Intel, pour faire court.

D'autres ont emboîté le pas et moins d'un an plus tard, 8 autres personnes sont parties et ont créé ensemble leur propre entreprise de conception et de fabrication d'électronique: Advanced Micro Devices (AMD, naturellement).

Le groupe était dirigé par Jerry Sanders, ancien directeur du marketing de Fairchild.Ils ont commencé par repenser les pièces de Fairchild et de National Semiconductor plutôt que d'essayer de concurrencer directement Intel, Motorola et IBM (qui ont dépensé des sommes importantes en recherche et en développement de nouveaux circuits intégrés).

Après ces modestes débuts et un déménagement rapide de Santa Clara à Sunnyvale (Silicon Valley en Californie), AMD a proposé des produits qui se sont vus offrir une efficacité, des tolérances au stress et une vitesse accrues en quelques mois. Ces micropuces ont été conçues pour se conformer aux normes de qualité militaires américaines, ce qui s'est avéré un avantage considérable dans l'industrie informatique encore jeune, où la fiabilité et la cohérence de la production variaient considérablement.

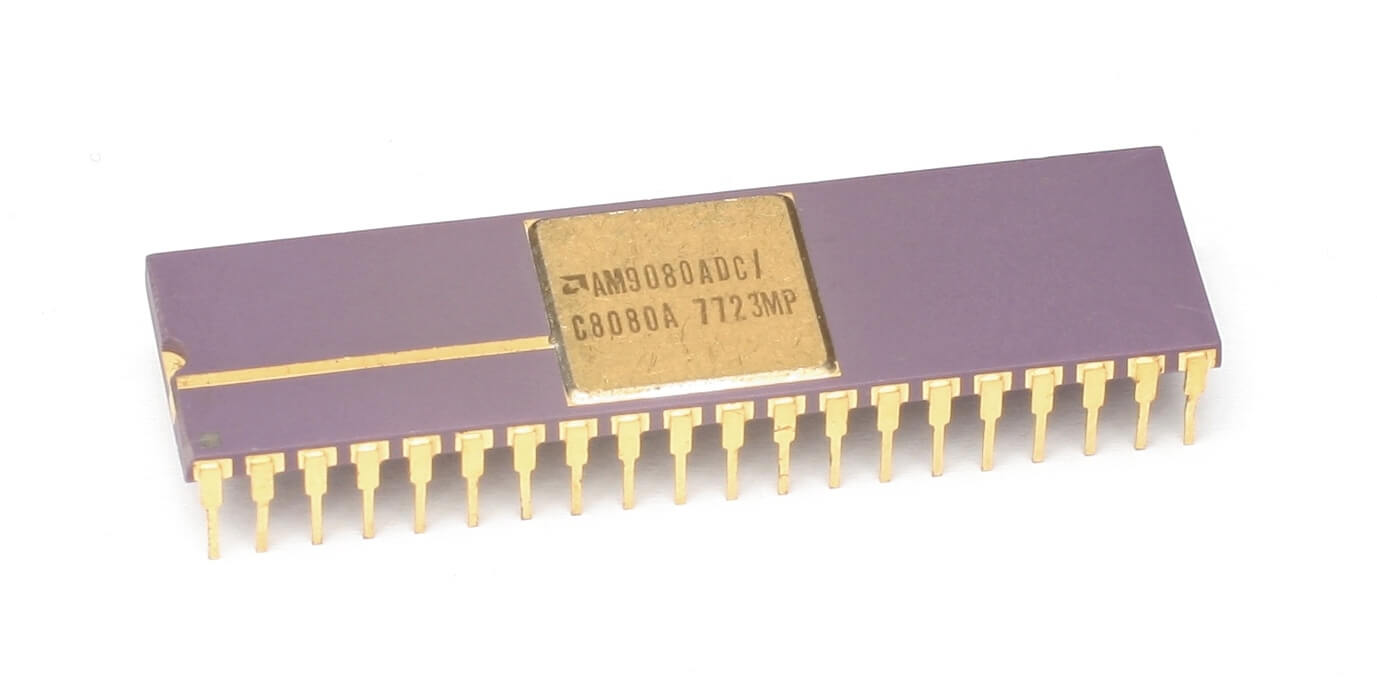

Au moment où Intel a sorti son premier microprocesseur 8 bits (le 8008) en 1974, AMD était une entreprise publique avec un portefeuille de plus de 200 produits – dont un quart étaient leurs propres conceptions, y compris des puces RAM, des compteurs logiques et des bits. manettes. L'année suivante a vu une série de nouveaux modèles: leur propre famille de circuits intégrés Am2900 (IC) et l'Am9080 2 bits 8 bits, une copie de l'ingénierie inverse du successeur d'Intel au 8008. Le premier était une collection de composants qui sont maintenant entièrement intégrés dans les processeurs et les GPU, mais il y a 35 ans, les unités logiques arithmétiques et les contrôleurs de mémoire étaient tous des puces distinctes.

Le plagiat flagrant de la conception d'Intel peut sembler quelque peu choquant par rapport aux normes d'aujourd'hui, mais il était normal pour les débuts des puces électroniques.

Le plagiat flagrant de la conception d'Intel peut sembler quelque peu choquant par rapport aux normes d'aujourd'hui, mais il était normal pour les débuts des puces électroniques. Le clone du processeur a finalement été renommé 8080A, après que AMD et Intel ont signé un accord de licence croisée en 1976. On pourrait imaginer que cela coûterait un sou ou deux, mais ce n'était que de 325 000 $ (1,65 million de dollars en dollars d'aujourd'hui).

L'accord a permis à AMD et Intel d'inonder le marché de puces ridiculement rentables, se vendant à un peu plus de 350 $ ou deux fois plus que pour les achats «militaires». Le processeur 8085 (3 MHz) suivit en 1977 et fut bientôt rejoint par le 8086 (8 MHz). Des améliorations de conception et de fabrication ont conduit à l'apparition du 8088 (5 à 10 MHz) en 1979, la même année qui a également vu la production commencer à l'usine AMD d'Austin, au Texas.

Quand IBM a commencé à passer des systèmes mainframe aux soi-disant ordinateurs personnels (PC) en 1982, le groupe a décidé d'externaliser les pièces plutôt que de développer des processeurs en interne. Le 8086 d'Intel, le tout premier processeur x86, a été choisi avec la stipulation expresse qu'AMD agissait comme source secondaire pour garantir un approvisionnement constant pour le PC / AT d'IBM.

Un contrat entre AMD et Intel a été signé en février de la même année, les premiers produisant des processeurs 8086, 8088, 80186 et 80188 – non seulement pour IBM, mais pour les nombreux clones IBM qui ont proliféré (Compaq n'en étant qu'un). . AMD a également commencé à fabriquer l'Intel 80286 16 bits, portant le nom d'Am286, vers la fin de 1982.

Cela devait devenir le premier processeur de PC de bureau vraiment important, et alors que les modèles d'Intel variaient généralement de 6 à 10 MHz, les AMD ont commencé à 8 MHz et ont atteint 20 MHz. Cela a sans aucun doute marqué le début de la bataille pour la domination du CPU entre les deux puissances de la Silicon Valley; ce qu'Intel a conçu, AMD a simplement essayé de faire mieux.

Cette période a représenté une énorme croissance du marché naissant des PC, et notant qu'AMD avait offert l'Am286 avec une augmentation significative de la vitesse par rapport au 80286, Intel a tenté d'arrêter AMD sur ses traces. Cela a été fait en les empêchant d'obtenir une licence pour la prochaine génération de processeurs 386.

AMD a intenté une action en justice, mais l'arbitrage a duré quatre ans et demi, et bien que le jugement ait conclu qu'Intel n'était pas obligé de transférer chaque nouveau produit à AMD, il a été déterminé que le plus grand fabricant de puces avait violé un engagement implicite de bonne foi.

Le refus de licence d'Intel s'est produit pendant une période critique, alors que le marché des PC IBM montait de 55% à 84%. Sans accès aux nouvelles spécifications du processeur, AMD a mis plus de cinq ans à procéder à la rétro-ingénierie du 80386 dans l'Am386. Une fois terminé, il s'est révélé une fois de plus plus qu'un match pour le modèle d'Intel. Là où l'original 386 a fait ses débuts à seulement 12 MHz en 1985, puis a réussi à atteindre 33 MHz, la version haut de gamme de l'Am386DX a été lancée en 1989 à 40 MHz.

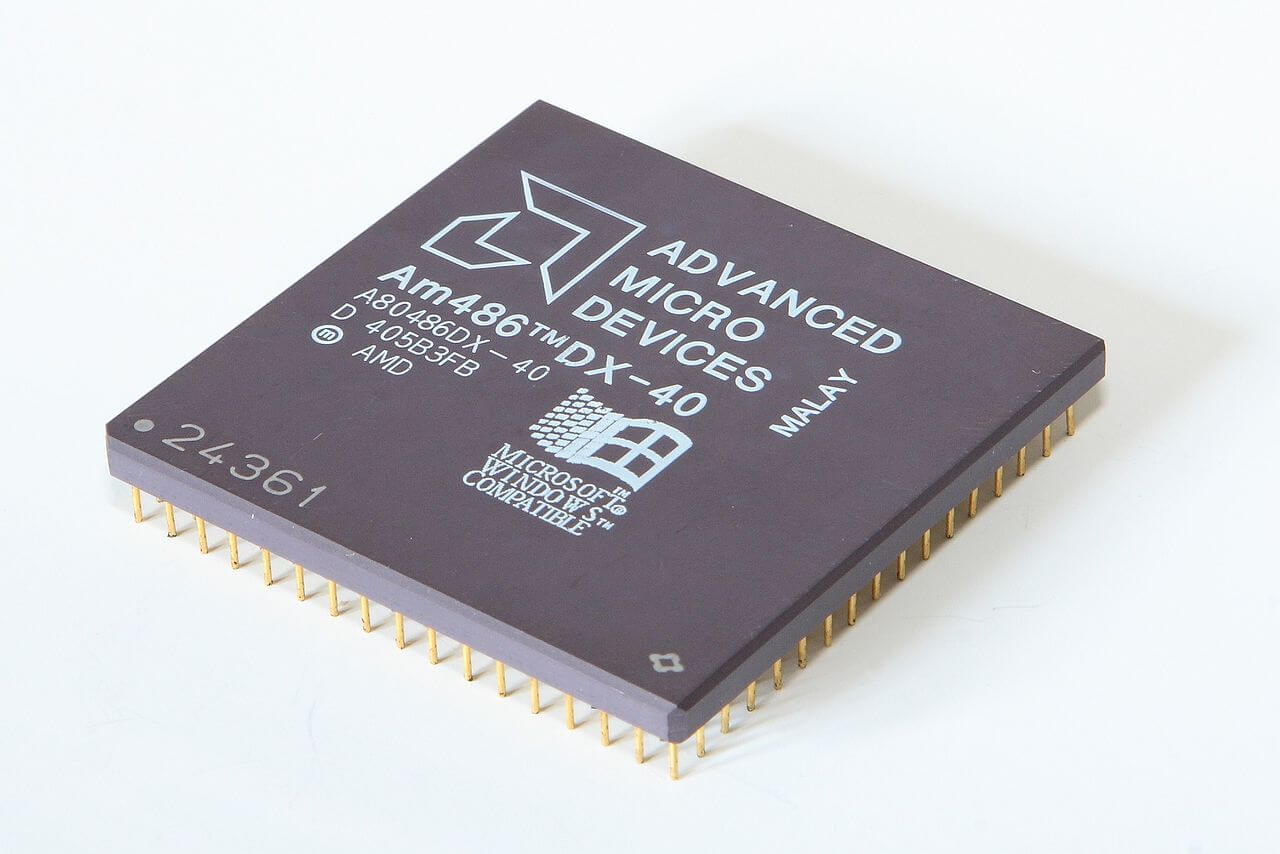

Le succès de l'Am386 a été suivi de la sortie de l'Am486 40 MHz très compétitif de 1993, qui offrait environ 20% de performances en plus que l'i486 33 MHz d'Intel pour le même prix. Cela devait être reproduit sur l'ensemble de la gamme 486, et tandis que le 486DX d'Intel atteignait 100 MHz, AMD offrait (quelque peu prévisible à ce stade) une option plus rapide de 120 MHz. Pour mieux illustrer la bonne fortune d'AMD au cours de cette période, les revenus de l'entreprise ont doublé, passant d'un peu plus d'un milliard de dollars en 1990 à bien plus de 2 milliards de dollars en 1994.

En 1995, AMD a introduit le processeur Am5x86 en tant que successeur du 486, en le proposant comme une mise à niveau directe pour les ordinateurs plus anciens.

En 1995, AMD a introduit le processeur Am5x86 en tant que successeur du 486, en le proposant comme une mise à niveau directe pour les ordinateurs plus anciens. L'Am5x86 P75 + offrait une fréquence de 150 MHz, avec des performances de référence «P75» similaires à celles du Pentium 75 d'Intel. Le «+» signifiait que la puce AMD était légèrement plus rapide en mathématiques entières que la concurrence.

Pour contrer cela, Intel a modifié ses conventions de dénomination pour se distancier des produits de son rival et d'autres fournisseurs. L'Am5x86 a généré des revenus importants pour AMD, à la fois grâce aux nouvelles ventes et aux mises à niveau de 486 machines. Comme pour les Am286, 386 et 486, AMD a continué d'étendre le marché des pièces en les proposant en tant que solutions intégrées.

Mars 1996 a vu l'introduction de son premier processeur, entièrement développé par les propres ingénieurs d'AMD: le 5k86, renommé plus tard en K5. La puce a été conçue pour concurrencer les processeurs Intel Pentium et Cyrix 6×86, et une solide exécution du projet était essentielle pour AMD – la puce devait avoir une unité à virgule flottante beaucoup plus puissante que Cyrix et à peu près égale au Pentium 100, tandis que les performances entières visaient le Pentium 200.

En fin de compte, c'était une occasion manquée, car le projet était entravé par des problèmes de conception et de fabrication. Il en est résulté que le processeur n'a pas atteint les objectifs de fréquence et de performances, et il est arrivé en retard sur le marché, ce qui a entraîné des ventes médiocres.

À ce moment-là, AMD avait dépensé 857 millions de dollars en actions pour NexGen, une petite entreprise de puces sans usine (conception uniquement) dont les processeurs étaient fabriqués par IBM. Le K5 d'AMD et le K6 de développement avaient des problèmes de mise à l'échelle à des vitesses d'horloge plus élevées (~ 150 MHz et plus) tandis que le Nx686 de NexGen avait déjà démontré une vitesse de base de 180 MHz. Après le rachat, le Nx686 est devenu le K6 d’AMD et le développement de la puce originale a été confié à la casse.

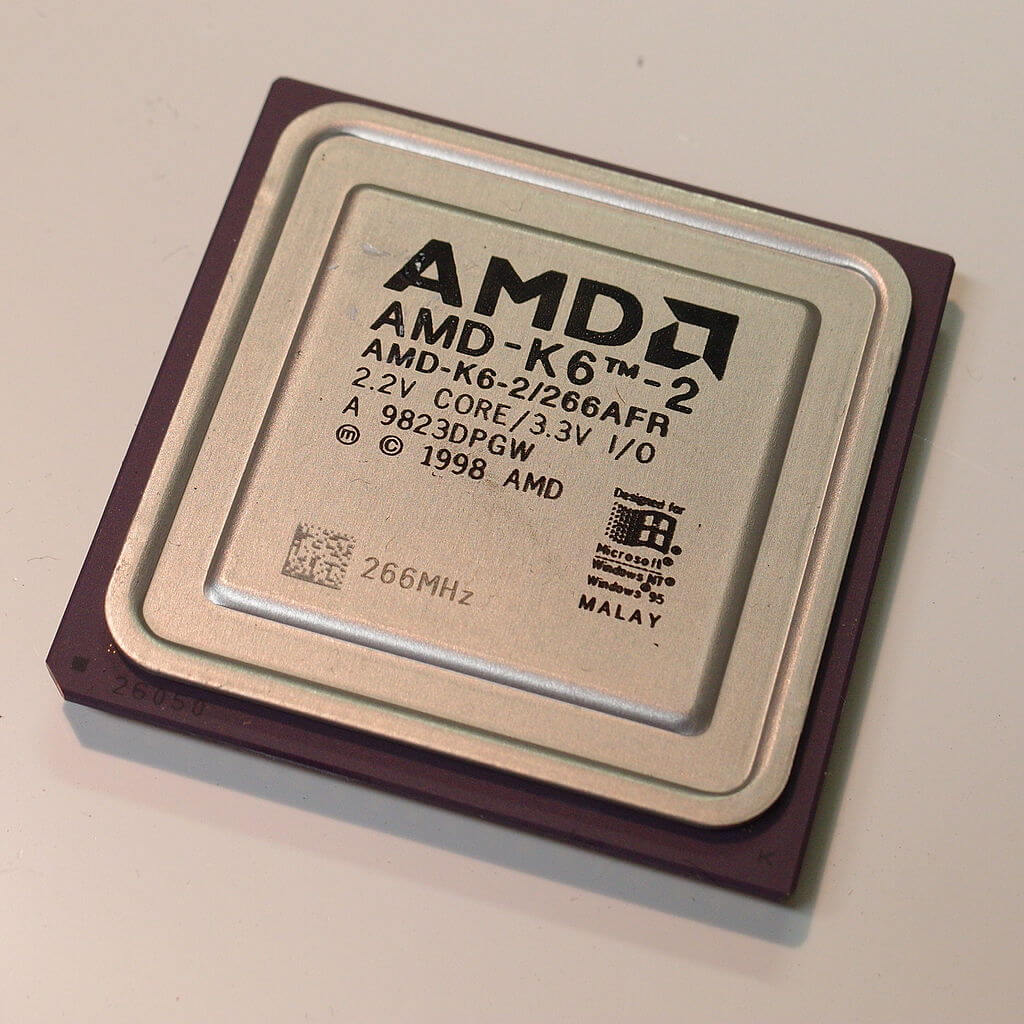

Le K6-2 a présenté 3DNow d'AMD! Jeu d'instructions SIMD (instruction unique, données multiples).

La montée en puissance d'AMD reflète le déclin d'Intel, depuis les débuts de l'architecture K6, opposée aux Pentium, Pentium II et (en grande partie rebadged) Pentium III d'Intel. Le K6 a accéléré le succès d'AMD, en raison de son existence et de ses capacités à un ancien employé d'Intel, Vinod Dham (alias le "Père du Pentium"), qui a quitté Intel en 1995 pour travailler chez NexGen.

Lorsque le K6 est sorti en 1997, il représentait une alternative viable au Pentium MMX. Le K6 est passé de force en force – d'une vitesse de 233 MHz dans le pas initial, à 300 MHz pour la révision "Little Foot" en janvier 1998, 350 MHz dans le "Chomper" K6-2 de mai 1998, et un étonnant 550 MHz en septembre 1998 avec la révision "Chomper Extended".

Le K6-2 a présenté 3DNow d'AMD! SIMD (instruction unique, données multiples) jeu d'instructions. Essentiellement identique à SSE d'Intel, il offrait un itinéraire plus facile d'accès aux capacités en virgule flottante du processeur; l'inconvénient est que les programmeurs devaient incorporer la nouvelle instruction dans tout nouveau code, en plus des correctifs et des compilateurs devant être réécrits pour utiliser la fonctionnalité.

Comme le K6 initial, le K6-2 représentait une bien meilleure valeur que la concurrence, coûtant souvent la moitié du prix des puces Pentium d'Intel. L'itération finale du K6, le K6-III, était un processeur plus compliqué, et le nombre de transistors était désormais de 21,4 millions – contre 8,8 millions dans le premier K6 et 9,4 millions pour le K6-II.

Il a incorporé PowerNow! D'AMD, qui a modifié dynamiquement les vitesses d'horloge en fonction de la charge de travail. Avec des vitesses d'horloge atteignant finalement 570 MHz, le K6-III était assez cher à produire et avait une durée de vie relativement courte écourtée par l'arrivée du K7 qui était mieux adapté pour rivaliser avec le Pentium III et au-delà.

1999 a été l'apogée de l'âge d'or d'AMD – l'arrivée du processeur K7, de marque Athlon, ont montré qu'ils n'étaient vraiment plus l'option de copie bon marché.

À partir de 500 MHz, les processeurs Athlon ont utilisé le nouveau slot A (EV6) et un nouveau bus système interne sous licence DEC qui fonctionnait à 200 MHz, éclipsant le processeur 133 MHz proposé à l'époque. Juin 2000 a apporté l'Athlon Thunderbird, un CPU apprécié par beaucoup pour son overclocking, qui incorporait le support de la RAM DDR et un cache on-die de niveau 2 à pleine vitesse.

Thunderbird et ses successeurs (Palomino, Thoroughbred, Barton et Thorton) ont combattu le Pentium 4 d'Intel au cours des cinq premières années du millénaire, généralement à un prix inférieur mais toujours avec de meilleures performances. Athlon a été amélioré en septembre 2003 avec le K8 (nom de code ClawHammer), mieux connu sous le nom de Athlon 64, car il a ajouté une extension 64 bits au jeu d'instructions x86.

Cet épisode est généralement cité comme le moment déterminant d'AMD. Alors qu'elle progressait, l'approche MHz à tout prix de l'architecture Intel Netburst était présentée comme un exemple classique d'une impasse de développement.

Le chiffre d'affaires et le résultat d'exploitation ont tous deux été excellents pour une si petite entreprise. Bien qu'il ne s'agisse pas de niveaux de revenus Intel, AMD était plein de succès et avide de plus. Mais lorsque vous êtes au sommet des plus hautes montagnes, il faut chaque once d'effort pour y rester – sinon, il n'y a qu'un moyen d'aller.

paradis perdu

Il n'y a pas un seul événement responsable de la chute de la DMLA de sa position élevée. Une crise économique mondiale, une mauvaise gestion interne, de mauvaises prévisions financières, une victime de son propre succès, les fortunes et les méfaits d'Intel – tout cela a joué un rôle, d'une manière ou d'une autre.

Mais commençons à voir comment les choses se passaient au début de 2006. Le marché des CPU était rempli d'offres d'AMD et d'Intel, mais le premier avait des goûts comme la série exceptionnelle Athlon 64 FX basée sur K8. Le FX-60 était un dual-core 2,6 GHz, tandis que le FX-57 était simple core, mais fonctionnait à 2,8 GHz.

Les deux étaient tête-et-épaules au-dessus de toute autre chose, comme le montrent les critiques de l'époque. Ils étaient extrêmement chers, avec le FX-60 au détail à plus de 1 000 $, mais il en était de même pour la crème de la crème d'Intel, le Pentium Extreme Edition 955 à 3,46 GHz. AMD semblait également avoir le dessus sur le marché des stations de travail / serveurs. , avec des puces Opteron surpassant les processeurs Xeon d'Intel.

Le problème d'Intel était leur architecture Netburst – la structure ultra-profonde du pipeline nécessitait des vitesses d'horloge très élevées pour être compétitif, ce qui augmentait à son tour la consommation d'énergie et la production de chaleur. La conception avait atteint ses limites et n'était plus à la hauteur.Intel a donc abandonné son développement et s'est tourné vers son ancienne architecture CPU Pentium Pro / Pentium M pour construire un successeur pour le Pentium 4.

L'initiative a d'abord produit le design Yonah pour les plates-formes mobiles, puis l'architecture Conroe dual-core pour les ordinateurs de bureau, en août 2006. Tel était le besoin d'Intel de sauver la face qu'ils ont relégué le nom Pentium aux modèles de budget bas de gamme et l'ont remplacé par Coeur – 13 ans de domination de la marque emportés en un instant.

Le passage à une conception de puces à faible puissance et à haut débit s'est avéré être parfaitement adapté à une multitude de marchés en évolution et presque du jour au lendemain, Intel a remporté la couronne de performances dans les secteurs grand public et amateurs. À la fin de 2006, AMD avait été fermement repoussé du sommet du CPU, mais c'était une décision de gestion désastreuse qui les avait poussés à descendre la pente.

Trois jours avant le lancement d'Intel du Core 2 Duo, AMD a rendu public une décision qui avait été entièrement approuvée par le PDG de l'époque, Hector Ruiz (Sanders avait pris sa retraite 4 ans plus tôt). Le 24 juillet 2006, AMD a annoncé son intention d'acquérir le fabricant de cartes graphiques ATI Technologies, pour un montant de 5,4 milliards de dollars (dont 4,3 milliards de dollars en espèces et en prêts et 1,1 milliard de dollars levés sur 58 millions d'actions). L'accord était un énorme pari financier, représentant 50% de la capitalisation boursière d'AMD à l'époque, et même si l'achat était logique, le prix ne l'était absolument pas.

Imageon, la division graphique portable d'ATI, a été vendue à Qualcomm dans le cadre d'un accord dérisoire de 65 millions de dollars. Cette division est maintenant nommée Adreno, une anagramme de "Radeon" et un composant intégral du Snapdragon SoC

ATI a été largement surévaluée, car elle n'a pas (ni Nvidia) tiré quelque chose de proche de ce type de revenus. ATI n'avait pas non plus de sites de fabrication – sa valeur était presque entièrement basée sur la propriété intellectuelle.

AMD a finalement reconnu cette erreur en absorbant 2,65 milliards de dollars de dépréciations en raison d'une surestimation de la valeur de l'écart d'acquisition d'ATI.

Pour aggraver le manque de prévoyance en matière de gestion, Imageon, la division graphique portable d'ATI, a été vendue à Qualcomm dans le cadre d'un accord dérisoire de 65 millions de dollars.Cette division s'appelle désormais Adreno, une anagramme de "Radeon" et une composante intégrante du Snapdragon SoC ( !).

Xilleon, un SoC 32 bits pour la télévision numérique et les câblosélecteurs, a été expédié à Broadcom pour 192,8 millions de dollars.

En plus de brûler de l'argent, la réponse éventuelle d'AMD à l'architecture actualisée d'Intel était clairement décevante. Deux semaines après la sortie de Core 2, le président et chef de l'exploitation d'AMD, Dirk Meyer, a annoncé la finalisation du nouveau processeur AMD K10 Barcelona. Ce serait leur décision décisive sur le marché des serveurs, car il s'agissait d'un processeur quadricœur à part entière, alors qu'à l'époque, Intel ne produisait que des puces Xeon double cœur.

La nouvelle puce Opteron est apparue en septembre 2007, en grande pompe, mais au lieu de voler le tonnerre d'Intel, le parti s'est officiellement arrêté avec la découverte d'un bogue qui, dans de rares circonstances, pouvait entraîner des blocages lors de l'écriture de cache imbriqué. Rare ou non, le bug TLB a mis un terme à la production d'AMD K10; en attendant, un correctif du BIOS qui a guéri le problème sur les processeurs sortants, le ferait à la perte d'environ 10% de performances. Au moment où les processeurs «B3 stepping» révisés ont été expédiés 6 mois plus tard, les dommages avaient été causés, à la fois pour les ventes et la réputation.

Un an plus tard, vers la fin de 2007, AMD a introduit la conception quadricœur K10 sur le marché des ordinateurs de bureau. À ce moment-là, Intel allait de l'avant et avait sorti le désormais célèbre Core 2 Quad Q6600. Sur le papier, le K10 était de conception supérieure – les quatre cœurs étaient tous dans le même moule, contrairement au Q6600 qui utilisait deux matrices distinctes sur le même boîtier. Cependant, AMD avait du mal à atteindre les vitesses d'horloge attendues, et la meilleure version du nouveau processeur n'était que de 2,3 GHz. C'était plus lent, quoique de 100 MHz, que le Q6600, mais c'était aussi un peu plus cher.

Mais l'aspect le plus déroutant de tout cela était la décision d'AMD de sortir avec un nouveau nom de modèle: Phenom. Intel est passé au Core car le Pentium était devenu synonyme de prix et de puissance excessifs et de performances relativement médiocres. D'un autre côté, Athlon était un nom que les passionnés d'informatique ne connaissaient que trop bien et il avait la vitesse pour égaler sa réputation. La première version de Phenom n'était pas vraiment mauvaise – elle n'était tout simplement pas aussi bonne que le Core 2 Quad Q6600, un produit qui était déjà facilement disponible, et Intel avait également des offres plus rapides sur le marché.

Bizarrement, AMD semblait faire un effort conscient pour s'abstenir de publicité. Ils n'avaient également aucune présence sur le côté logiciel de l'entreprise; une façon très curieuse de gérer une entreprise, et encore moins une lutte dans le commerce des semi-conducteurs. Mais aucun examen de cette ère dans l'histoire d'AMD ne serait complet sans prendre en considération les actes anticoncurrentiels d'Intel. À ce stade, AMD luttait non seulement contre les puces d'Intel, mais également contre les activités monopolistiques de l'entreprise, qui consistaient notamment à payer aux OEM des sommes importantes – des milliards au total – pour empêcher activement les processeurs AMD des nouveaux ordinateurs.

Au premier trimestre 2007, Intel a payé 723 millions de dollars à Dell pour rester le seul fournisseur de ses processeurs et chipsets, ce qui représente 76% du bénéfice d'exploitation total de la société de 949 millions de dollars. AMD gagnerait plus tard un règlement de 1,25 milliard de dollars en la matière, étonnamment bas en surface, mais probablement exacerbé par le fait qu'au moment des manigances d'Intel, AMD lui-même ne pouvait pas fournir suffisamment de CPU à ses clients existants.

Pas qu'Intel ait besoin de faire tout cela. Contrairement à AMD, ils avaient un objectif fixe à long terme, ainsi qu'une plus grande diversité de produits et IP. Ils avaient également des réserves de trésorerie comme personne d'autre: à la fin de la première décennie du nouveau millénaire, Intel tirait plus de 40 milliards de dollars de revenus et 15 milliards de dollars de revenus d'exploitation. Cela a fourni d'énormes budgets pour le marketing, la recherche et le développement de logiciels, ainsi que des fonderies spécialement adaptées à ses propres produits et à son calendrier. Ces facteurs à eux seuls ont permis à AMD de lutter pour sa part de marché.

Un trop-payé de plusieurs milliards de dollars pour l'ATI et les intérêts sur les prêts, un successeur décevant du K8 et des puces problématiques arrivant tard sur le marché, étaient tous des pilules amères à avaler. Mais les choses allaient empirer.

Un pas en avant, un latéralement, n'importe quel nombre en arrière

En 2010, l'économie mondiale avait du mal à rebondir après la crise financière de 2008. AMD avait éjecté sa section de mémoire flash quelques années plus tôt, ainsi que toutes ses fonderies de fabrication de puces – elles sont finalement devenues GlobalFoundries, qu'AMD utilise toujours pour certains ses produits. Environ 10% de ses effectifs ont été supprimés et, ensemble, les économies et l'injection de liquidités ont permis à AMD de se concentrer et de se concentrer entièrement sur la conception du processeur.

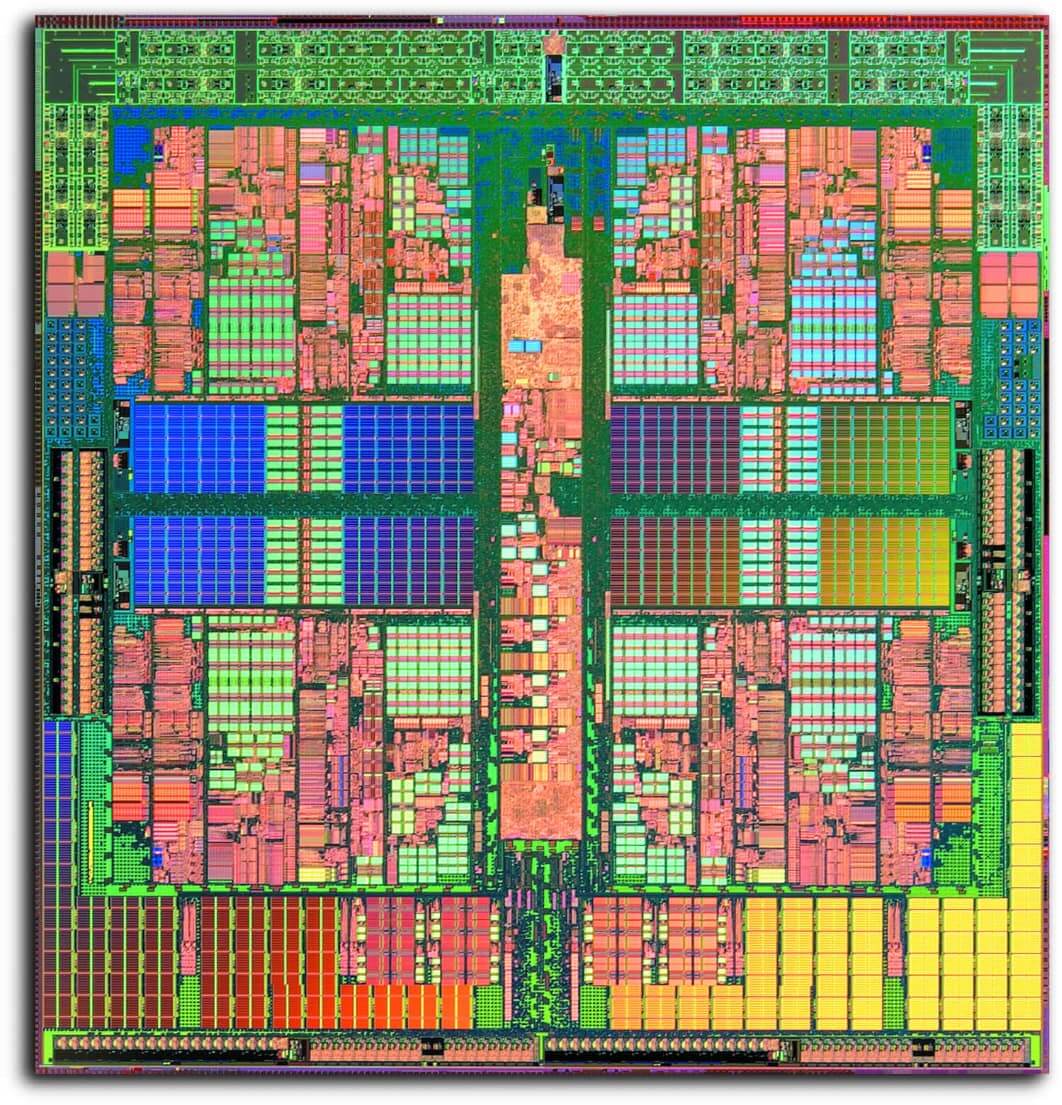

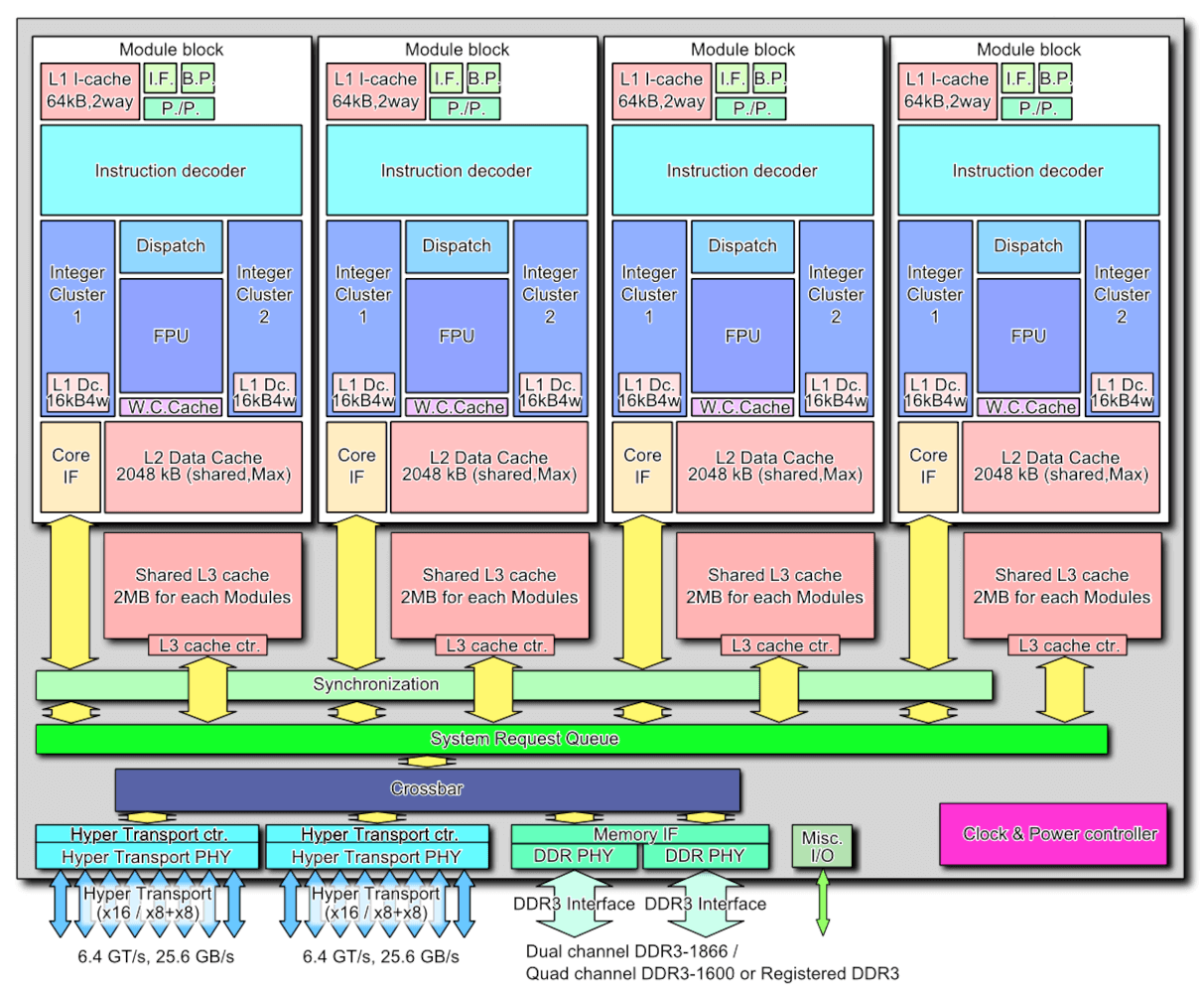

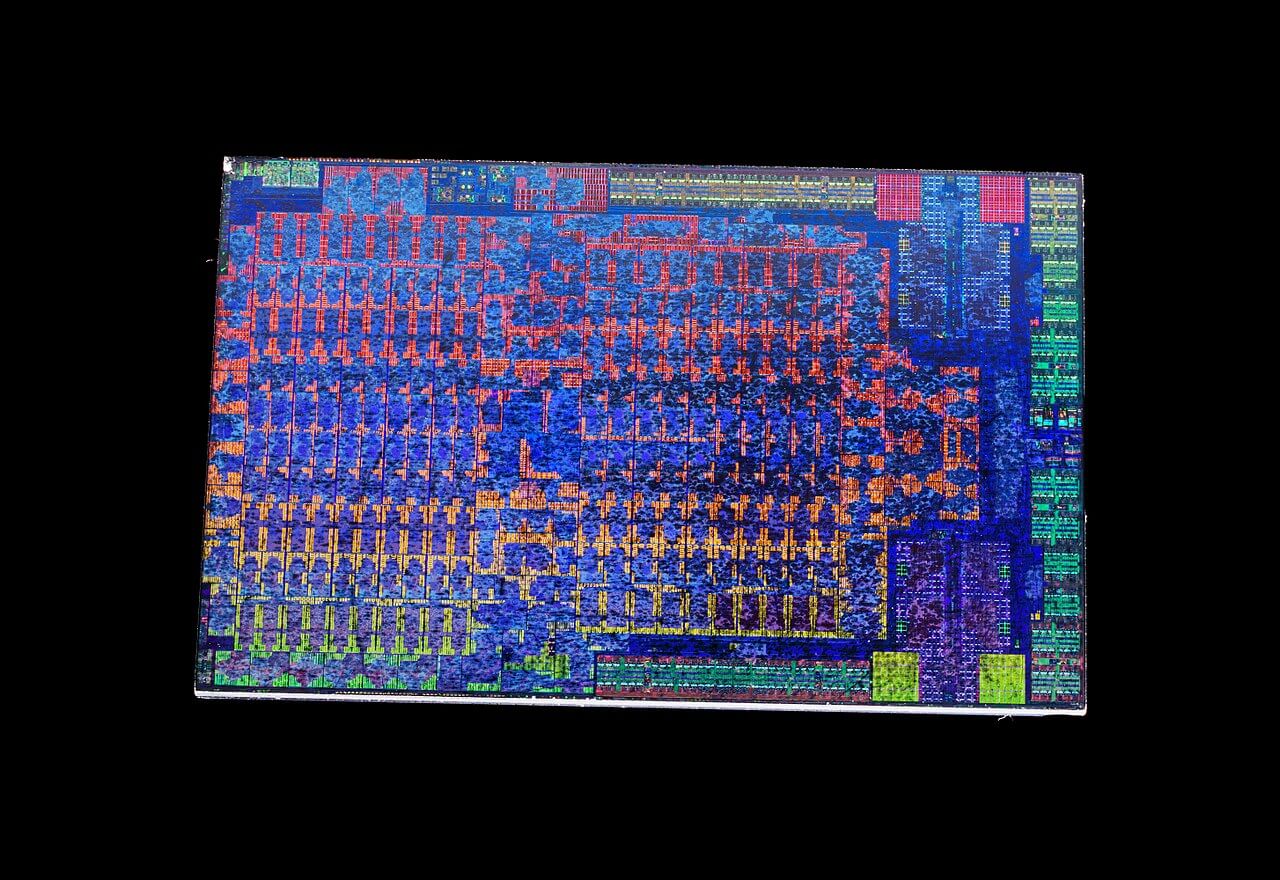

Plutôt que d'améliorer la conception du K10, AMD a recommencé avec une nouvelle structure et vers la fin de 2011, l'architecture Bulldozer a été lancée. Là où K8 et K10 étaient de véritables processeurs multicœurs et multithread simultanés (SMT), la nouvelle disposition a été classée comme «multithreading en cluster».

AMD a adopté une approche modulaire partagée avec Bulldozer – chaque cluster (ou module) contenait deux cœurs de traitement entiers, mais ils n'étaient pas totalement indépendants. Ils ont partagé l'instruction L1 et les caches de données L2, l'extraction / décodage et l'unité à virgule flottante. AMD est même allé jusqu'à abandonner le nom Phenom et revenir à l'époque glorieuse de l'Athlon FX, en nommant simplement les premiers processeurs Bulldozer comme AMD FX.

L'idée derrière tous ces changements était de réduire la taille globale des puces et de les rendre plus économes en énergie. Des matrices plus petites amélioreraient les rendements de fabrication, conduisant à de meilleures marges, et l'augmentation de l'efficacité aiderait à augmenter les vitesses d'horloge. La conception évolutive le rendrait également adapté à un plus large éventail de marchés.

Le meilleur modèle lors du lancement d'octobre 2011, le FX-8510, arborait 4 clusters mais était commercialisé en tant que CPU 8 cœurs et 8 threads. À cette époque, les processeurs avaient plusieurs vitesses d'horloge et la fréquence de base du FX-8150 était de 3,6 GHz, avec une horloge turbo de 4,2 GHz. Cependant, la puce avait une taille de 315 mm2 et avait une consommation électrique maximale de plus de 125 W.Intel avait déjà publié le Core i7-2600K: il s'agissait d'un processeur traditionnel à 4 cœurs et à 8 threads, fonctionnant jusqu'à 3,8 GHz. Elle était nettement plus petite que la nouvelle puce AMD, à 216 mm2, et consommait 30 W de puissance en moins.

Sur le papier, le nouveau FX aurait dû dominer, mais ses performances étaient quelque peu décevantes – parfois, la capacité à gérer de nombreux threads brillait, mais les performances à un seul thread n'étaient souvent pas meilleures que la gamme Phenom qu'il devait remplacer, malgré les vitesses d'horloge supérieures.

Ayant investi des millions de dollars dans la R&D de Bulldozer, AMD n'allait certainement pas abandonner la conception et l'achat d'ATI commençait à porter ses fruits. Au cours de la décennie précédente, la première incursion d'AMD dans un ensemble combiné CPU et GPU, appelé Fusion, a été tardive sur le marché et décevante.

Mais le projet a fourni à AMD les moyens de s’attaquer à d’autres marchés. Plus tôt en 2011, une autre nouvelle architecture avait été publiée, appelée Bobcat.

Destiné aux applications de faible puissance, telles que les systèmes embarqués, les tablettes et les ordinateurs portables; c'était aussi la conception polaire opposée à Bulldozer: juste une poignée de pipelines et rien d'autre. Bobcat a reçu une mise à jour bien nécessaire quelques années plus tard, dans l'architecture Jaguar, et a été sélectionné par Microsoft et Sony pour alimenter la Xbox One et la PlayStation 4 en 2013.

Bien que les marges bénéficiaires soient relativement minces, les consoles étant généralement construites au prix le plus bas possible, les deux plates-formes se sont vendues par millions, ce qui a mis en évidence la capacité d'AMD à créer des SoC personnalisés.

Le Bobcat d'AMD a reçu une mise à jour de l'architecture Jaguar et a été sélectionné par Microsoft et Sony pour alimenter la Xbox One et la PlayStation 4 en 2013.

AMD a continué à réviser la conception du Bulldozer au fil des ans – Piledriver est arrivé en premier et nous a donné le FX-9550 (une monstruosité de 220 W, 5 GHz), mais Steamroller et la version finale, Excavator (lancée en 2011, avec des produits l'utilisant pendant 4 ans plus tard), étaient plus axés sur la réduction de la consommation d'énergie, plutôt que d'offrir quelque chose de particulièrement nouveau.

À ce moment-là, la structure de dénomination des CPU était devenue pour le moins déroutante. Phenom a longtemps été résigné dans les livres d'histoire, et FX avait une mauvaise réputation. AMD a abandonné cette nomenclature et vient de qualifier ses processeurs de bureau Excavator de Une série.

La section graphique de l'entreprise, qui présentait les produits Radeon, avait des fortunes similaires. AMD a conservé la marque ATI jusqu'en 2010, en la remplaçant par la leur. Ils ont également complètement réécrit l'architecture GPU créée par ATI fin 2011, avec la sortie de Graphics Core Next (GCN). Cette conception durerait près de 8 ans et trouverait sa place dans les consoles, les ordinateurs de bureau, les postes de travail et les serveurs; il est toujours utilisé aujourd'hui comme GPU intégré dans les soi-disant processeurs APU d'AMD.

Les processeurs GCN ont grandi pour offrir d'immenses performances de calcul, mais la structure n'était pas la plus simple pour en tirer le meilleur parti. La version la plus puissante jamais créée par AMD, le GPU Vega 20 de la Radeon VII, offrait 13,4 TFLOP de puissance de traitement et 1024 Go / s de bande passante – mais dans les jeux, il ne pouvait tout simplement pas atteindre les mêmes hauteurs que le meilleur de Nvidia .

Les produits Radeon ont souvent la réputation d'être chauds, bruyants et très gourmands en énergie. L'itération initiale de GCN, qui alimentait le HD 7970, nécessitait bien plus de 200 W de puissance à pleine charge – mais il a été fabriqué sur un nœud de processus relativement grand, 28 nm de TSMC. Au moment où GCN avait atteint sa pleine maturité, sous la forme du Vega 10, les puces étaient fabriquées par GlobalFoundries sur leur nœud de 14 nm, mais les besoins énergétiques n'étaient pas meilleurs avec des Radeon RX Vega 64 consommant un maximum de près de 300 W.

Alors qu'AMD avait une sélection de produits décente, ils n'étaient tout simplement pas aussi bons qu'ils auraient dû l'être et ils ont eu du mal à gagner suffisamment d'argent.

| Année financière | Revenus (milliards $) | Marge brute | Bénéfice d'exploitation (en millions de dollars) | Bénéfice net (en millions de dollars) |

| 2016 | 4.27 | 23% | -372 | -497 |

| 2015 | 4.00 | 27% | -481 | -660 |

| 2014 | 5,51 | 33% | -155 | -403 |

| 2013 | 5.30 | 37% | 103 | -83 |

| 2012 | 5.42 | 23% | -1060 | -1180 |

| 2011 | 6,57 | 45% | 368 | 491 |

À la fin de 2016, le bilan de la société avait subi une perte pendant 4 années consécutives (les états financiers de 2012 ont été battus par une radiation définitive de 700 millions de dollars de GlobalFoundries). L'endettement était toujours élevé, même avec la vente de ses fonderies et d'autres succursales, et même le succès du package système sur Xbox et PlayStation n'a pas fourni suffisamment d'aide.

À première vue, AMD semblait être en grande difficulté.

Nouvelles étoiles a-ryze

N'ayant plus rien à vendre et aucun signe d'investissements importants à venir pour les sauver, AMD ne pouvait que faire une chose: doubler et restructurer. En 2012, ils ont recruté deux personnes qui viendraient jouer un rôle vital dans la relance de la société des semi-conducteurs.

Jim Keller, l'ancien architecte en chef de la gamme K8, était revenu après une absence de 13 ans et avait entrepris de diriger deux projets: l'un une conception ARM pour les marchés des serveurs, l'autre une architecture x86 standard, avec Mike Clark (responsable concepteur de Bulldozer) étant l'architecte en chef.

Il était accompagné de Lisa Su, qui avait été vice-présidente principale et directrice générale de Freescale Semiconductors. Elle a occupé le même poste chez AMD et est généralement créditée, avec le président de l'époque, Rory Read, comme étant à l'origine de l'entrée de l'entreprise sur des marchés autres que le PC, en particulier les consoles.

Deux ans après la restauration de Keller dans la section R&D d'AMD, le PDG Rory Read a démissionné et le SVP / GM a augmenté. Titulaire d'un doctorat en génie électronique du MIT et ayant mené des recherches sur les MOSFETS SOI (silicium sur isolant), Su avait la formation universitaire et l'expérience industrielle nécessaires pour ramener AMD à ses jours de gloire. Mais rien ne se passe du jour au lendemain dans le monde des processeurs à grande échelle – la conception des puces prend au mieux plusieurs années avant d'être prête à être commercialisée. AMD devrait affronter la tempête jusqu'à ce que de tels projets puissent se concrétiser.

Tandis qu'AMD continuait de lutter, Intel allait de plus en plus fort. L'architecture du cœur et les nœuds du processus de fabrication avaient bien évolué et, à la fin de 2016, ils ont enregistré un chiffre d'affaires de près de 60 milliards de dollars. Depuis un certain nombre d'années, Intel suit uneTIC Tac«approche du développement du processeur: un»cocher"serait une nouvelle architecture, alors qu'un"tock'serait un raffinement de processus, généralement sous la forme d'un nœud plus petit.

Cependant, tout ne se passait pas bien dans les coulisses, malgré les énormes profits et la domination quasi totale du marché. En 2012, Intel devrait publier des processeurs sur un nœud de pointe de 10 nm d'ici 3 ans. Ce particulier tock jamais arrivé – en effet, l'horloge n'a jamais vraiment coché, Soit. Leur premier processeur 14 nm, utilisant l'architecture Broadwell, est apparu en 2015 et le nœud et la conception fondamentale sont restés en place pendant une demi-décennie.

Les ingénieurs des fonderies ont rencontré à plusieurs reprises des problèmes de rendement avec 10 nm, forçant Intel à affiner les processus et l'architecture plus anciens chaque année. Les vitesses d'horloge et la consommation d'énergie ont augmenté de plus en plus, mais aucun nouveau design n'était à venir; un écho, peut-être, de leurs jours Netburst. Les clients de PC se sont retrouvés avec des choix frustrants: choisissez quelque chose dans la puissante gamme Core, mais payez un prix élevé, ou choisissez la série FX / A plus faible et moins chère.

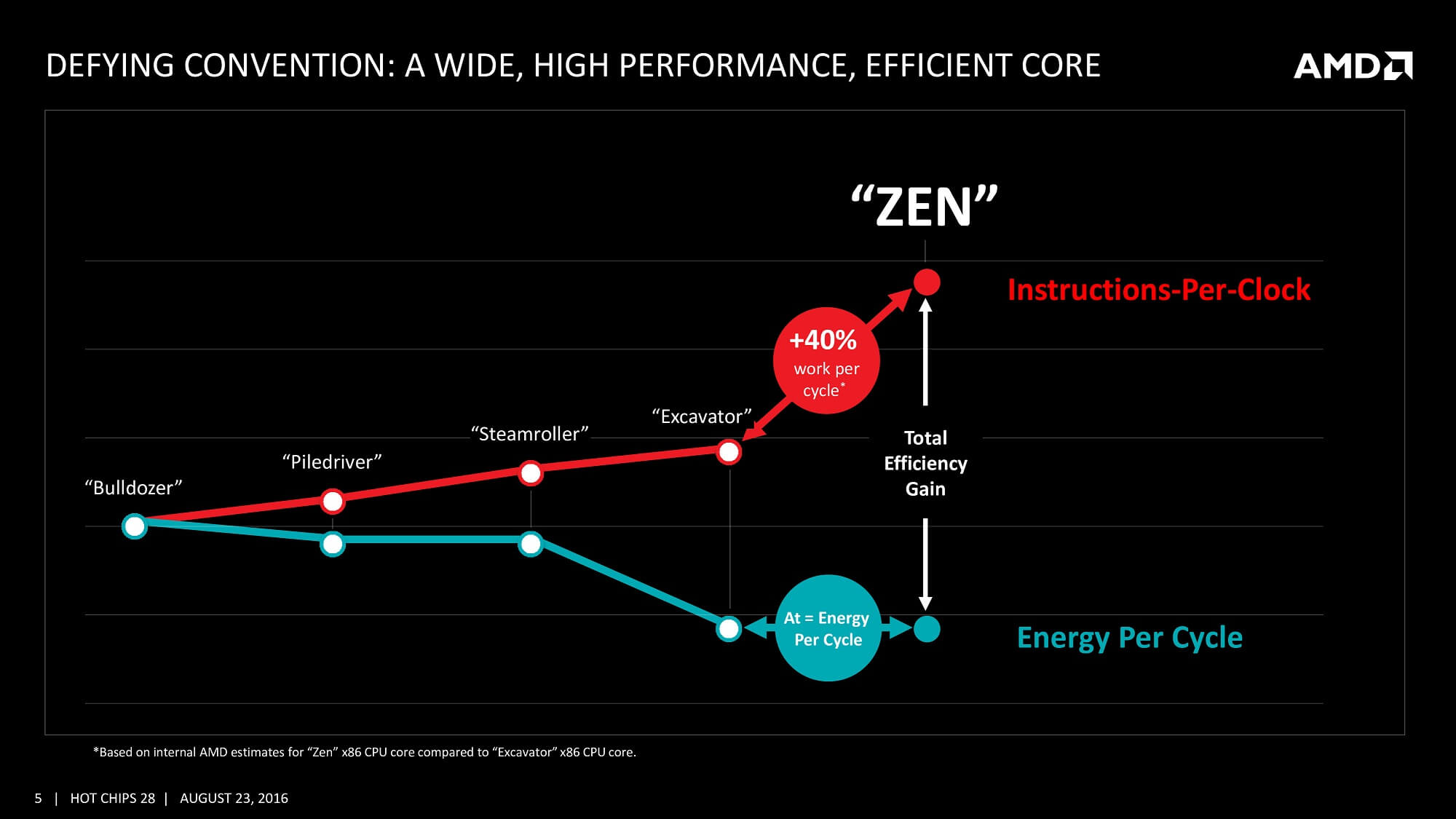

Mais AMD avait discrètement construit un jeu de cartes gagnant et joué sa main en février 2016, lors de l'événement annuel de l'E3. En utilisant le redémarrage très attendu de Doom comme plate-forme d'annonce, la toute nouvelle architecture Zen a été révélée au public.

Très peu de choses ont été dites sur la nouvelle conception, à part des expressions telles que «multithreading simultané», «cache à large bande passante» et «conception finFET économe en énergie». Plus de détails ont été donnés au cours de Computex 2016, y compris un objectif d'une amélioration de 40% par rapport à l'architecture de l'excavatrice.

Dire que c'était ambitieux serait un euphémisme

Dire que cela était ambitieux serait un euphémisme – en particulier compte tenu du fait qu'AMD a, au mieux, apporté des augmentations modestes de 10% à chaque révision de la conception du bulldozer.

Il leur faudrait encore 12 mois avant que la puce n'apparaisse, mais quand c'est le cas, le plan de longue durée d'AMD était enfin clair.

Toute nouvelle conception matérielle a besoin du bon logiciel pour le vendre, mais les processeurs multi-threads étaient confrontés à une bataille difficile. Malgré les consoles dotées de processeurs 8 cœurs, la plupart des jeux étaient encore parfaits avec seulement 4. Les principales raisons étaient la domination d'Intel sur le marché et la conception de la puce AMD sur Xbox One et PlayStation 4. Le premier avait sorti son premier processeur 6 cœurs. en 2010, mais c'était extrêmement cher (près de 1 100 $). D'autres sont apparus rapidement, mais il faudra encore sept ans avant qu'Intel ne propose un processeur hexa-core vraiment abordable, le Core i5-8400, à moins de 200 $.

Le problème avec les processeurs de console était que la configuration du processeur se composait de deux processeurs à 4 cœurs dans le même dé, et qu'il y avait une latence élevée entre les deux sections de la puce. Les développeurs de jeux avaient donc tendance à garder les threads du moteur situés sur l'une des sections et à n'utiliser l'autre que pour les processus d'arrière-plan généraux. Ce n'est que dans le monde des postes de travail et des serveurs qu'il y avait un besoin de processeurs sérieusement multi-threads – jusqu'à ce qu'AMD en décide autrement.

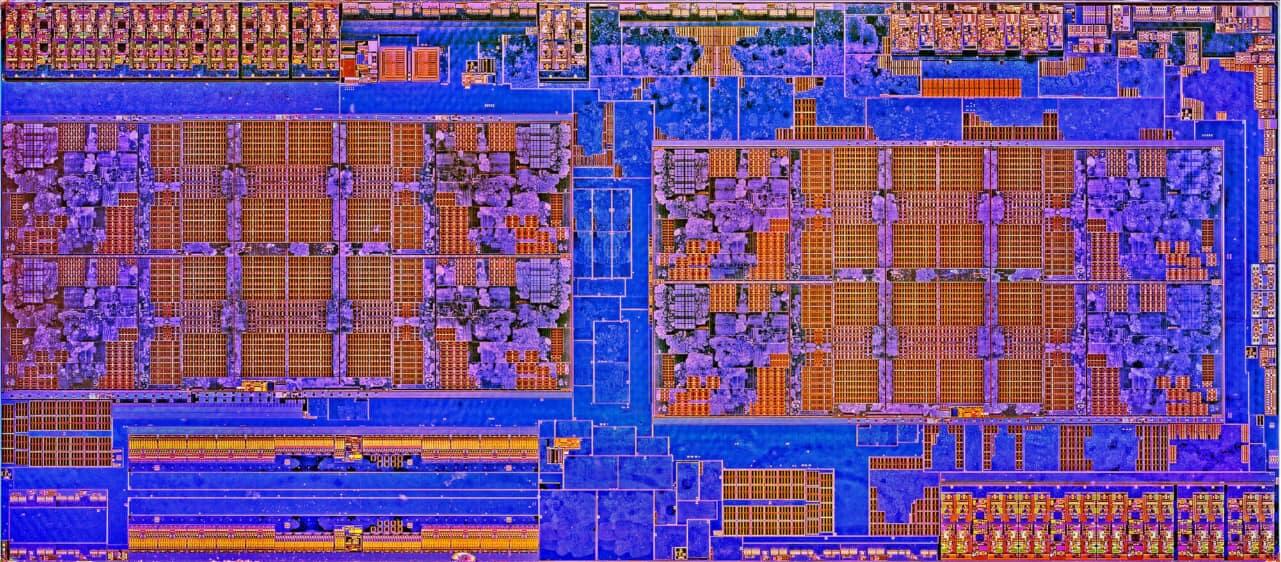

En mars 2017, les utilisateurs de bureau généraux pouvaient mettre à niveau leurs systèmes avec l'un des deux processeurs 8 cœurs et 16 threads. A completely new architecture clearly deserved a new name, and AMD cast off Phenom and FX, to give us Ryzen.

Neither CPU was particularly cheap: the 3.6 GHz (4 GHz boost) Ryzen 7 1800X retailed at $500, with the 0.2 GHz slower 1700X selling for $100 less. In part, AMD was keen to stop the perception of being the budget choice, but it was mostly because Intel was charging over $1,000 for their 8-core offering, the Core i7-6900K.

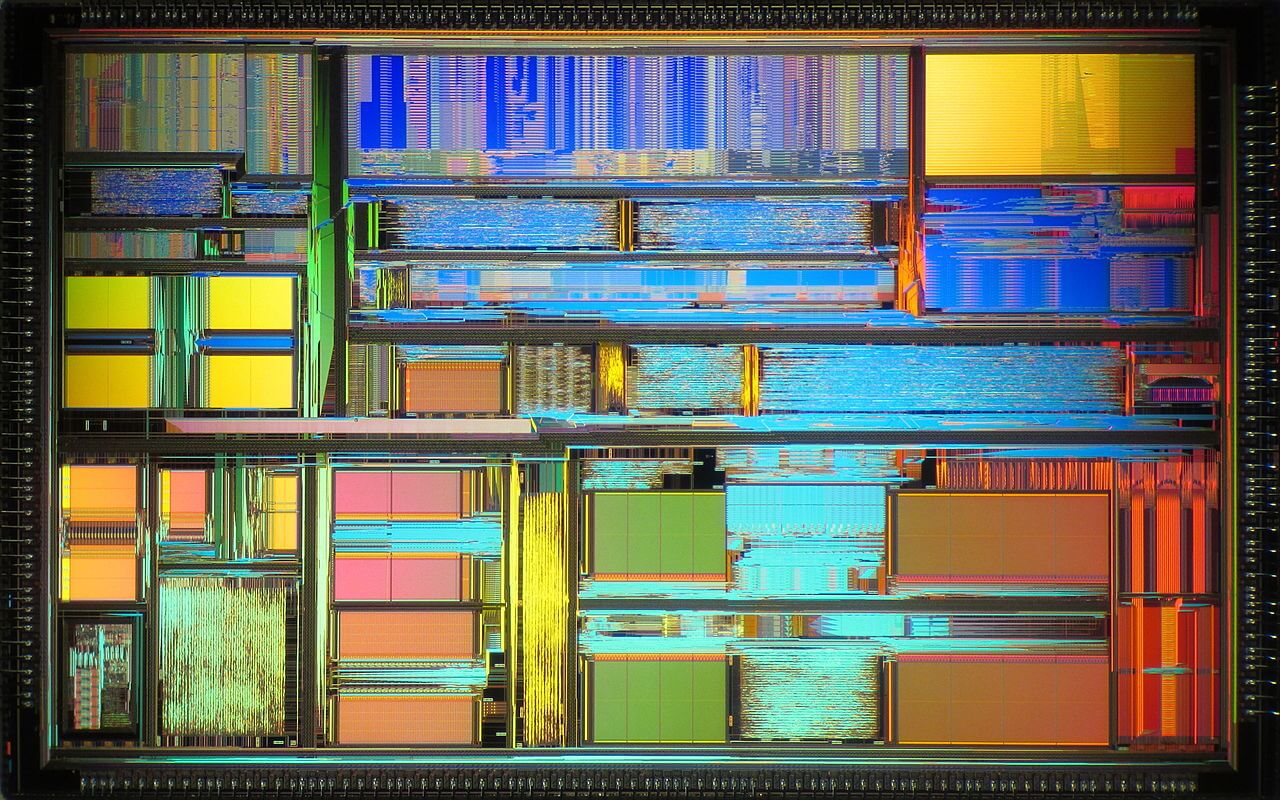

Zen took the best from all previous designs and melded them into a structure that focused on keeping the pipelines as busy as possible; and to do this, required significant improvements to the pipeline and cache systems. The new design dropped the sharing of L1/L2 caches, as used in Bulldozer, and each core was now fully independent, with more pipelines, better branch prediction, and greater cache bandwidth.

Reminiscent of the chip powering Microsoft and Sony's consoles, the Ryzen CPU was also a system-on-a-chip

Reminiscent of the chip powering Microsoft and Sony's consoles, the Ryzen CPU was also a system-on-a-chip; the only thing it lacked was a GPU (later budget Ryzen models included a GCN processor).

The die was sectioned into two so-called CPU Complexes (CCX), each of which were 4-core, 8-threads. Also packed into the die was a Southbridge processor — the CPU offered controllers and links for PCI Express, SATA, and USB. This meant motherboards, in theory, could be made without an SB but nearly all did, just to expand the number of possible device connections.

All of this would be for nothing if Ryzen couldn't perform, and AMD had a lot to prove in this area after years of playing second fiddle to Intel. The 1800X and 1700X weren't perfect: as good than anything Intel had for professional applications, but slower in games.

AMD had other cards to play: a month after the first Ryzen CPUs hit the market, came 6 and 4-core Ryzen 5 models, followed two months later by 4-core Ryzen 3 chips. They performed against Intel's offerings in the same manner as their larger brothers, but they were significantly more cost effective.

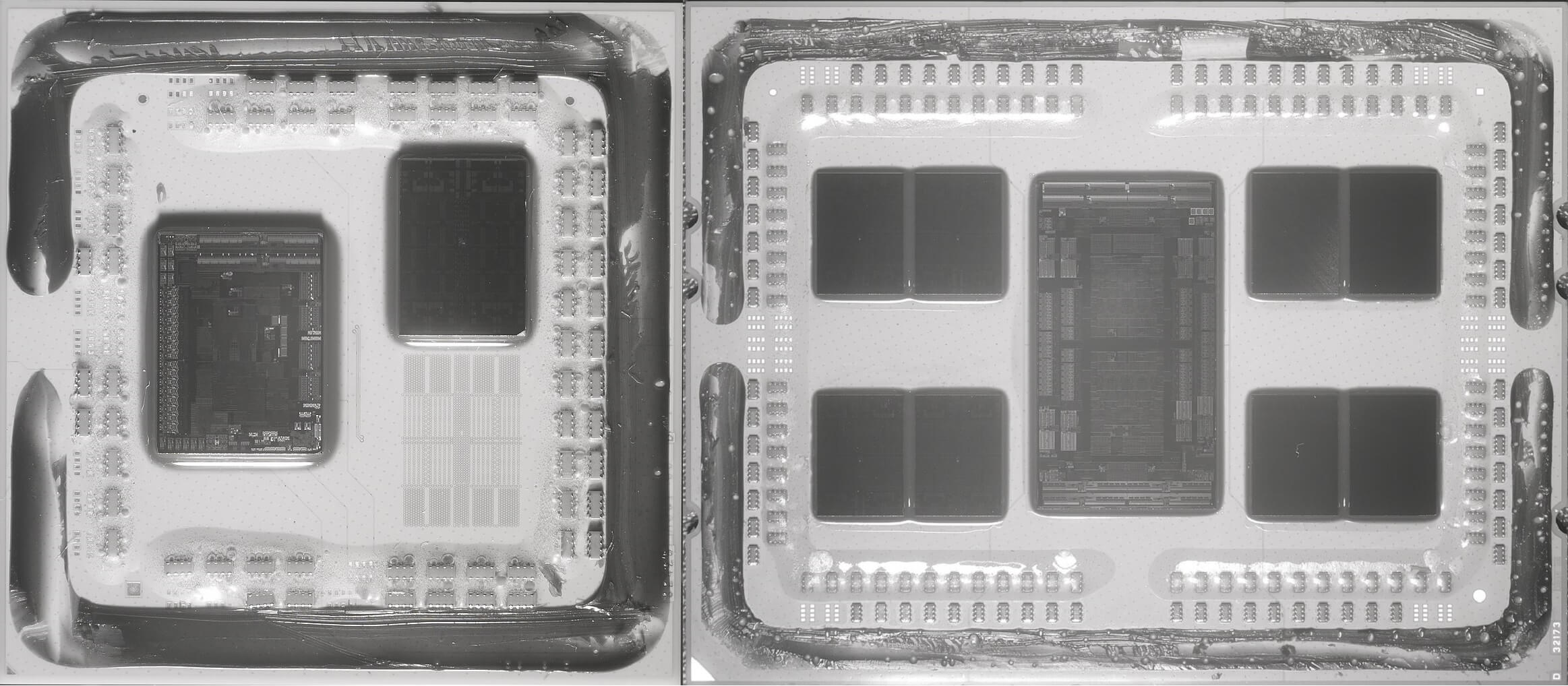

And then came the aces — the 16-core, 32-thread Ryzen Threadripper 1950X (with an asking price of $1,000) and the 32-core, 64-thread EPYC processor for servers. These behemoths comprised two and four Ryzen 7 1800X chips, respectively, in the same package, utilizing the new Infinity Fabric interconnect system to shift data between the chips.

In the space of six months, AMD showed that they were effectively targeting every x86 desktop market possible, with a single, one-size-fits-all design.

A year later, the architecture was updated to Zen+, which consisted of tweaks in the cache system and switching from GlobalFoundries' venerable 14LPP process — a node that was under from Samsung — to an updated, denser 12LP system. The CPU dies remained the same size, but the new fabrication method allowed the processors to run at higher clock speeds.

AMD launched Zen 2: this time the changes were more significant and the term chiplet became all the rage

Another 12 months after that, in the summer of 2019, AMD launched Zen 2. This time the changes were more significant and the term chiplet became all the rage. Rather than following a monolithic construction, where every part of the CPU is in the same piece of silicon (which Zen and Zen+ do), the engineers separated in the Core Complexes from the interconnect system.

The former were built by TSMC, using their N7 process, becoming full dies in their own right — hence the name, Core Complex Die (CCD). The input/output structure was made by GlobalFoundries, with desktop Ryzen models using a 12LP chip, and Threadripper & EPYC sporting larger 14 nm versions.

The chiplet design will be retained and refined for Zen 3, currently penned for release late in 2020. We're not likely to see the CCDs break Zen 2's 8-core, 16-thread layout, instead it'll be a similar improvement as seen with Zen+ (i.e. cache, power efficiency, and clock speed improvements).

It's worth taking stock with what AMD achieved with Zen. In the space of 8 years, the architecture went from a blank sheet of paper to a comprehensive portfolio of products, containing $99 4-core, 8-thread budget offerings through to $4,000+ 64-core, 128-thread server CPUs.

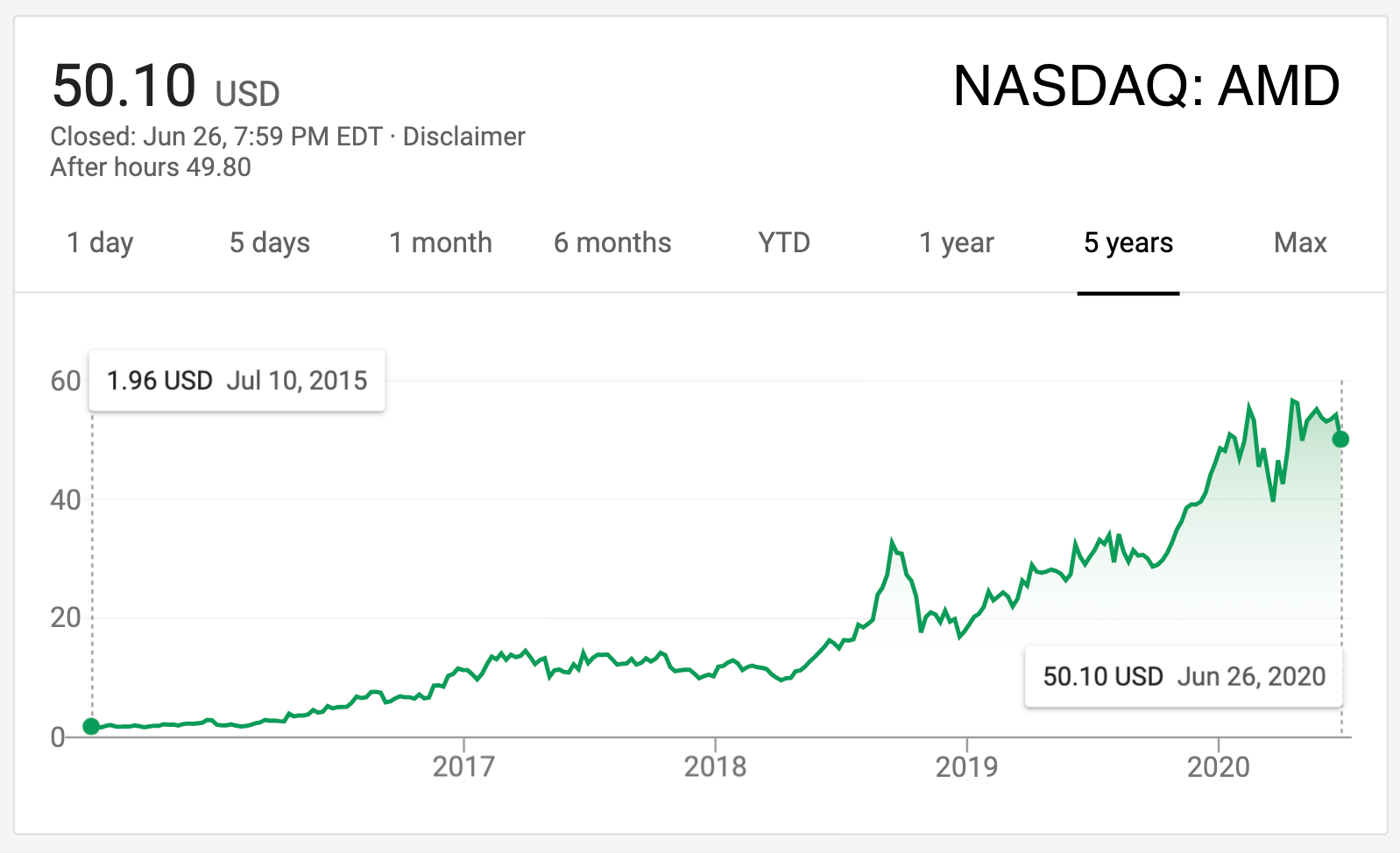

AMD's finances have changed dramatically as well: from losses and debts running into the billions, AMD is now on track to clear its loans and post an operating income in excess of $600 million, within the next year. While Zen may not be the sole factor in the company's financial revival, it has helped enormously.

AMD's graphics division has seen similar changes in fortune — in 2015, the section was given full independence, as the Radeon Technologies Group (RTG). The most significant development from their engineers came in the form of RDNA, a significant reworking of GCN. Changes to the cache structure, along with adjustments to the size and grouping of the compute units, shifted the focus of the architecture directly towards gaming.

The first models to use this new architecture, the Radeon RX 5700 series, demonstrated the design's serious potential. This was not lost on Microsoft and Sony, as they both selected Zen 2 and the updated RDNA 2, to power their forthcoming new Xbox and PlayStation 5 consoles.

AMD is quantifiably back to where it was in the Athlon 64 days in terms of architecture development and technological innovation. They rose to the top, fell from grace, and like a beast from mythology, created their own rebirth from the ashes.

Although the Radeon Group hasn't enjoyed the same level of success as the CPU division, and their graphics cards are perhaps still seen as the "value option," AMD is quantifiably back to where it was in the Athlon 64 days in terms of architecture development and technological innovation. They rose to the top, fell from grace, and like a beast from mythology, created their own rebirth from the ashes.

Looking ahead with caution

It's perfectly suitable to ask a simple question about AMD: could they return to the dark days of dismal products and no money?

Even if 2020 proves to be an excellent year for AMD and positive Q1 financial results show a 40% improvement to the previous year, $9.4 billion of revenue still puts them behind Nvidia ($10.7 billion in 2019) and light years away from Intel ($72 billion). The latter has a much larger product portfolio, of course, and its own foundries, but Nvidia's income is reliant almost entirely on graphics cards.

It's clear that both revenue and operating income need to grow, in order to fully stabilize AMD's future — so how could this be achieved? The bulk of their income is from what they call the Computing and Graphics segment, i.e. Ryzen and Radeon sales. This will undoubtedly continue to improve, as Ryzen is very competitive and the RDNA 2 architecture will provide a common platform for games that work as well on PCs as they do on next-generation consoles.

Intel's latest desktop CPUs hold an ever decreasing lead in gaming. They also lack the breadth of features that Zen 3 will offer. Nvidia holds the GPU performance crown, but faces stiff competition in the mid-range sector from Radeons. It's perhaps nothing more than a coincidence, but even though RTG is a fully independent division of AMD, its revenue and operating income are grouped with the CPU sector — this suggests that their graphics cards, while popular, do not sell in the same quantities as their Ryzen products do.

Possibly a more pressing issue for AMD is that their Enterprise, Embedded and Semi-Custom segment accounted for just under 20% of the Q1 2020 revenue, and ran at an operating loss. This may be explained by the fact that current-gen Xbox and PlayStation sales have stagnated, in light of the success of Nintendo's Switch and forthcoming new models from Microsoft and Sony. Intel has also utterly dominated the enterprise market and nobody running a multi-million dollar datacenter is going to throw it all out, just because an amazing new CPU is available.

But this could change over the next couple of years, partly through the new game consoles, but also from an unexpected alliance. Nvidia, of all companies, picked AMD over Intel as the choice of CPU for their new deep learning/AI compute clusters, the DGX 100. The reason is straightforward: the EPYC processor has more cores and memory channels, and faster PCI Express lanes than anything Intel has to offer.

If Nvidia is happy to use AMD's products, others will certainly follow suit. AMD will have to keep climbing a steep mountain, but today it'd appear they have the right tools for the job. As TSMC continues to tweak and refine its N7 process node, all AMD chips made using the process are going to be incrementally better, too.

Looking forward, there are a few areas within AMD that could use genuine improvement. One such area is marketing. The 'Intel Inside' catchphrase and jingle have been ubiquitous for over 30 years, and while AMD spends some money promoting Ryzen, ultimately they need makers such as Dell, HP, and Lenovo to sell units sporting their processors in the same light and specifications, as they do with Intel's.

On the software side, there's been plenty of work on applications that enhance users' experience, such as Ryzen Master, but it was just recently that Radeon drivers were having widespread problems. Gaming drivers can be hugely complex, but the quality of them can make or break the reputation of a piece of hardware.

AMD is currently in the strongest position that they've ever been in its 51-year history. With the ambitious Zen project showing no signs of hitting any limits soon, the company's phoenix-like rebirth has been a tremendous success. They're not at the top of the mountain though, and perhaps for the better. It's said that history always repeats itself, but let's hope that this doesn't come to pass. A healthy and competitive AMD, fully able to meet Intel and Nvidia head-on, only brings benefits to users.

What are your thoughts on AMD and its trials and tribulations — did you own a K6 chip, or perhaps an Athlon? What's your favorite Radeon graphics card? Which Zen-based processor are you most impressed by? Share your comments in the section below.